Навигация

ЭНТРОПИЯ ИСТОЧНИКА НЕПРЕРЫВНЫХ СООБЩЕНИЙ

2. ЭНТРОПИЯ ИСТОЧНИКА НЕПРЕРЫВНЫХ СООБЩЕНИЙ

ДИФФЕРЕНЦИАЛЬНАЯ ЭНТРОПИЯ

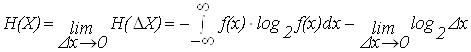

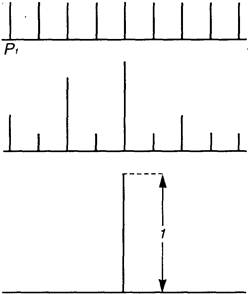

Для описания информационных свойств непрерывного источника (сигнала) используется понятие дифференциальной энтропии. Для ее получения воспользуемся формулой для энтропии дискретных сообщений. В соответствии с графиком функции плотности вероятности (рис. 6.) можно записать p(xi) =![]() ? . Где p(xi) - вероятность того, что x лежит в пределах i-го шага квантования.

? . Где p(xi) - вероятность того, что x лежит в пределах i-го шага квантования.

f(x)

f(xi)

0 Dx xi x

Рис. 6. График функции плотности вероятности

При этом, выражение для энтропии можно представить в виде

(9)

(9)

Переходим к пределу:

.

.

Полная энтропия источника непрерывных сообщений состоит из двух слагаемых, одно из которых определяется законом распределения, а второе является постоянной величиной, определяющей шаг квантования, который влияет на точность измерений. Этот член выражения определяет постоянную составляющую и исключается из рассмотрения.

Значение первого слагаемого определяется законом распределения и характеризует дифференциальную энтропию непрерывного источника (т. к. f(x) - плотность вероятности или дифференциальный закон распределения)

![]() , (20)

, (20)

Дифференциальная энтропия- часть энтропии источника непрерывных сообщений, которая зависит от плотности вероятности сигнала x(t), выдаваемого источником.

Различные классы физических явлений и процессов подчиняются различным законам распределения. Непрерывные сигналы полностью характеризуются законами распределения (интегральным или дифференциальным). На любые реальные сигналы накладываются определенные ограничения, например: по средней мощности (нагрев аппаратуры); по мгновенной или пиковой мощности (перегрузки).

Так как дифференциальная энтропия зависит от плотности вероятности, определим, для какого закона она максимальна. Т. е. при каком распределении вероятности, сигнал заданной мощности имеет максимальную энтропию. Для нахождения максимального значения энтропии необходимо воспользоваться вариационной теоремой с использованием неопределенных множителей Лагранжа при условиях нормировки и неизменности среднего квадрата:

![]() ;

; ![]() .

.

При этом,

![]()

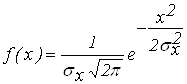

Решив уравнения, получим симметричный нормальный закон распределения

. (11)

. (11)

Если среднюю мощность не ограничивать

то получим равномерный закон распределения.

Определим дифференциальную энтропию для нормального распределения, т. е. сигнала с ограниченной средней мощностью. Полученное в результате решения вариационной задачи нормальное распределение является симметричным. Если в интеграле для дифференциальной энтропии произвести замену x = y-mx,то интеграл не изменится, а значит, энтропия не зависит от математического ожидания и равна энтропии центрированной случайной величины.

![]() Определим максимальное значение для энтропии:

Определим максимальное значение для энтропии:

Дифференциальная энтропия для нормального распределения равна:

![]() (12)

(12)

Полная энтропия для нормального распределения равна:

. (13)

. (13)

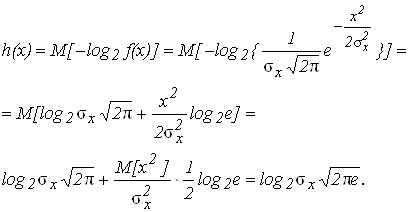

Если учесть что h(x)- это математическое ожидание функции [-log2 f(x)] от случайной величины x с плотностью f(x), то можно записать.

В соответствии с центральной предельной теоремой нормальным законам распределения подчиняются широкий класс, так называемых гауссовых случайных процессов или реальных сигналов.

Белый шум - помеха с наиболее ''зловредными" свойствами , т. е. передает максимальное количество вредящих сведений при заданной средней мощности и позволяет упростить расчеты для наихудшего случая.

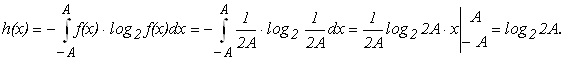

Для того чтобы сигнал с ограниченной пиковой мощностью имел максимальную информативность необходимо, чтобы он имел равномерное распределение (рис. 9). Определим дифференциальную энтропию для равномерного распределения, т. е. сигнала с ограниченной пиковой мощностью. Если P-пиковая мощность, то ![]() - максимальная амплитуда. Уравнение для дифференциальной энтропии с учетом ограничений имеет вид:

- максимальная амплитуда. Уравнение для дифференциальной энтропии с учетом ограничений имеет вид:

Дифференциальная энтропия для равномерного распределения равна:

![]() (14)

(14)

Полная энтропия сигнала с равномерным распределением равна:

![]() , (15)

, (15)

где m-число уровней квантования.

Определим дифференциальную энтропию для экспоненциального распределения. Это распределение широко используется для определения интенсивности отказов в радиоэлектронной аппаратуре

Полная энтропия для экспоненциального распределения равна:

![]() . (16)

. (16)

Список Литературы

1. Коганов А. В. Векторные меры сложности, энтропии, информации. “Математика. Компьютер. Образование”. Вып. 7, ч. 2, “Прогресс-Традиция”, М., 2000, с. 540 — 546

2. Яглом А. М., Яглом И. М. Вероятность и информация. М., 1957.

3. Шеннон К. Работы по теории информации и кибернетике. — М.: Изд. иностр. лит., 1963. — 830 с.

4. Волькенштейн М. В. Энтропия и информация. — М.: Наука, 1986. — 192 с.

5. Цымбал В. П. Теория информации и кодирование. — М.: Выща Школа, 1977. — 288 с.

6. Вероятностные методы в вычислительной технике. /Под ред. А.Н. Лебедева, Е.А.Чернявского. –М.: Высш. шк., 1986.

7. Седов Е.А. Взаимосвязь информации, энергии и физической энтропии в процессах управления и самоорганизации. Информация и управление. М., Наука, 1986.

Похожие работы

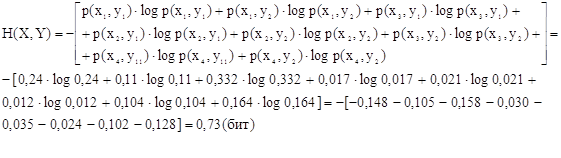

... — В (дождь) и (отсутствие осадков); соответствующие таблицы вероятностей имеют вид: Опыт β1 исходы В вероятн. 0,4 0,6 Опыт β2 исходы В вероятн. 0,8 0,2 Следовательно, энтропии опытов β1 и β2 равны Н (β1 ) = -0,4 log 0,4 — 0,6 log 0,6 0,97 бита, Н (β2) = - 0,8 log 0,8 - 0,2 log 0,2 0,72 бита. Пусть ...

... порядок чередования букв формируется согласно правилам, заданным верхними иерархическими уровнями текста, то есть не «снизу вверх», а «сверху вниз». Что же касается используемой теорией информации вероятностной функции энтропии, то она может быть использована в качестве точного математического инструмента только на нижних уровнях иерархии текста, поскольку только на этих уровнях удается найти ...

стемы. Содержание Нормативные ссылки Введение 1 Расчет информационных характеристик источников дискретных сообщений 2 Расчет информационных характеристик дискретного канала 3 Согласование дискретного источника с дискретным каналом 4 Дискретизация и квантование Заключение Нормативные ссылки В настоящем отчете использованы ссылки на следующие стандарты: - ГОСТ 1.5 – 93 ...

... именно метод скользящего экзамена или некоторые его вариации. Стоит отметить, что эффективность статистических методов классификации сейсмических сигналов также проверяется методом скользящего экзамена. Таким образом, применяя его для тестирования нейросетевого подхода, можно корректно сравнить результаты экспериментов с возможностями стандартных методов. 7. Программная реализация. При ...

0 комментариев