Навигация

Контрольная работа

По курсу: Теория информации и кодирования

На тему: Энтропия сигналов

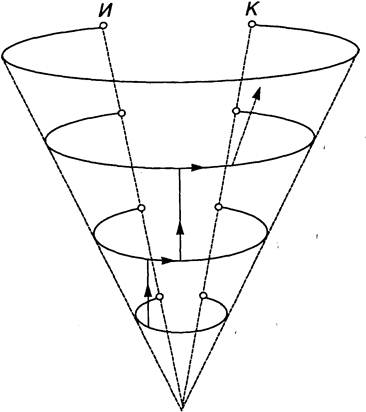

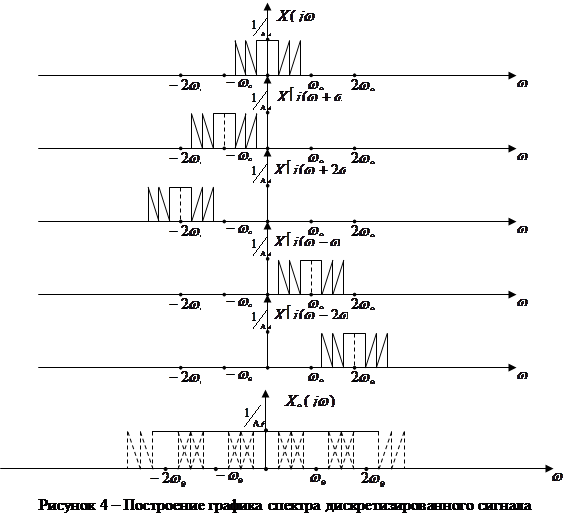

1. ЭНТРОПИЯ ОБЪЕДИНЕНИЯ

Объединение - совокупность двух и более ансамблей дискретных, случайных событий. С объединением связаны понятия условной, безусловной, совместной и взаимной энтропии.

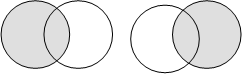

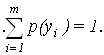

1. Безусловная энтропия - среднее количество информации, приходящееся на один символ (рис. 1). Если Х – передаваемое, а У- принимаемое сообщения, то можно записать следующие соотношения:

|

X Y X Y

X Y X Y

Рис. 1. Безусловная энтропия

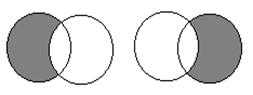

2. Условная энтропия - количество информации об источнике, когда известно, что принимается Y, или мера количества информации в приемнике когда известно, что передается X (рис. 2).

|

X Y X Y

Рис. 2. Условная энтропия

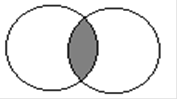

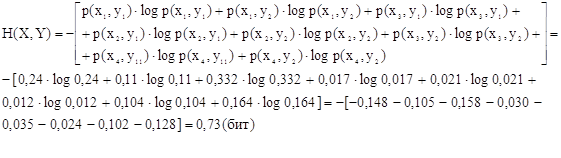

3. Совместная энтропия - среднее количество информации на пару пе-реданных и принятых символов (рис. 3).

H(X,Y) = H(Y,X) = H(X)+H(Y/X)= H(Y)+H(X/Y)= H(X)+H(Y)-H(X×Y).

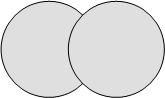

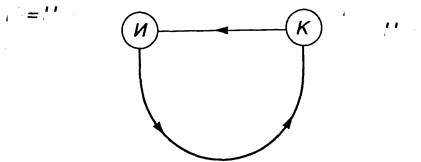

4. Взаимная энтропия - энтропия совместного появления статистически-зависимых сообщений (рис. 4).

H(X×?Y)=H(Y×X)=H(X)-H(X/Y)=H(Y)-H(Y/X)=H(X,Y)-H(X/Y)- H(Y/X).

X Y

Рис. 3 Совместная энтропия

X Y

Рис. 4. Взаимная энтропия

На практике чаще всего встречаются взаимозависимые символы и сообщения. Например, при передаче текстовых сообщений передаются не просто буквы, а слова, имеющие определенные смысловые значения. При этом, каждая буква, и сочетание букв имеют различные вероятности появления в тексте. Условная энтропия учитывает взаимосвязь событий через их условные вероятности.

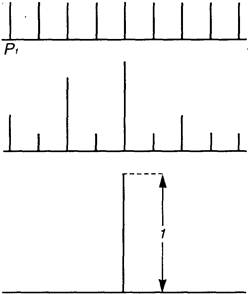

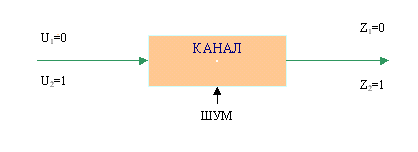

Рассмотрим схему рис. 5:

![]()

![]()

|

|

Рис. 5. Передача сообщений

Источник сообщений X- вырабатывает сообщения, элементами которого являются символы алфавита источника {x1,x2,...,xm }, вероятности появления на выходе которых равны p(x1), p(x2), ..., p(xm) ,при этом:

![]()

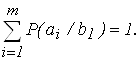

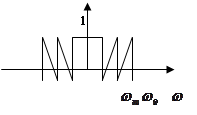

Энтропия источника представляет собой неопределенность появления на выходе источника сообщений символа первичного алфавита и определяется соотношением:

![]() ()

()

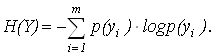

Приемник сообщений Y- принимает сообщения, элементами которого являются символы алфавита приемника {y1,y2,...,ym }, вероятности появления на входе которых равны p(y1), p(y2),..., p(ym), при этом:

Энтропия приемника представляет собой неопределенность появления на входе приемника сообщений символа после его появления на выходе источника и определяется соотношением:

(2)

(2)

Если в канале связи отсутствуют потери информации (нет помех, ис-кажений и т. д.), то символу xi соответствует символ yi . В противном случае xi может быть принят как любой из возможных y1 ,y2 ,...,ym , с соответствующими вероятностями.

При отсутствии потерь: H(X) = H(Y). При наличии помех они уничто-жают часть информации. При этом потери информации можно определить через частные и общую условную энтропию.

Вычисление общей условной энтропии удобно производить с помощью канальных матриц ( матрицей переходных состояний).

Потери информации в канале можно оценивать со стороны источника или приемника сообщений.

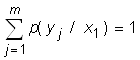

Рассмотрим порядок определения потерь со стороны источника (известен передаваемый сигнал). При этом, условная вероятность p(yj /xi) означает вероятность того, что при передаче сообщения xi получено сообщение yj. Канальная матрица имеет вид, приведенный в табл. 1.

Таблица 1

|

X | y1 y2 ym |

| x1 x2

xm | p(y1/x1) p(y2/x1) . . . p(ym/x1) p(y1/x2) p(y2/x2) . . . p(ym/x2) p(y1/xm) p(y2/xm) . . . p(ym/xm) |

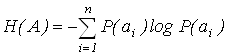

При этом:

.

.

Вероятности, расположенные на диагонали характеризует вероятность правильного приема, остальные – ложного, чем они расположены дальше от диагонали, тем они меньше. При отсутствии помех в канале связи элементы матрицы, расположенные по диагонали, равны единице, а все остальные равны нулю. Канальные матрицы всегда квадратные, т. к. количество передаваемых сигналов, равно количеству принятых, хотя вероятность прохождения отдельных сигналов может быть равна нулю.

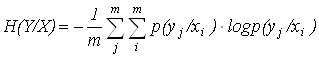

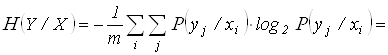

Потери информации, вызванные действием помех, определяются с помощью условной энтропии. Для равновероятных сигналов на выходе источника общая условная энтропия вычисляется по формуле:

. (3)

. (3)

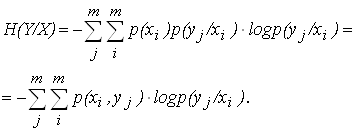

Для не равновероятных сигналов на выходе источника общая условная энтропия вычисляется по формуле:

(4)

(4)

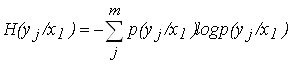

Частная условная энтропия определяет потери информации, приходящиеся на долю какого – либо конкретного сигнала (например, потери для сигнала x1)

. (5)

. (5)

При отсутствии помех вероятность получения правильного сигнала станет безусловной, а условная энтропия будет равна нулю.

Для исследования канала со стороны приемника (известен полученный сигнал) - условная вероятность p(xi /yi) означает вероятность того, что при приеме сообщения yiбыло передано сообщение xi.

Канальная матрица имеет вид, приведенный в табл. 2.

Таблица 2

| Y X | y1 y2 ym |

| x1 x2 xm | p(x1/y1) p(x1/y2) . . . p(x1/ym) p(x2/y1) p(x2/y2) . . . p(x2/ym) p(xm/y1) p(xm/y2) . . . p(xm/ym) |

Вероятности расположения на диагонали характеризует вероятность правильной передачи, остальные – ложной. Для равновероятных сигналов на входе приемника общая условная энтропия вычисляется по формуле:

. (6)

. (6)

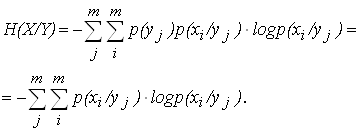

Для не равновероятных сигналов на входе приемника общая условная энтропия вычисляется по формуле:

( 17)

( 17)

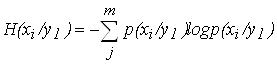

Частная условная энтропия, определяющая потери, приходящиеся на долю сигнала y1, равна:

. (8)

. (8)

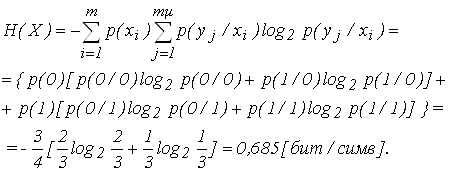

Пример 1. Вычислить энтропию источника сообщений, выдающего два символа 0 и 1 с вероятностями p(0)=3/4, p()=1/4 и условными вероятностями: p(0/0)=2/3, p(/0)=1/3, p(0/1)=1, p(/1)=0, т. е. после 1 всегда идет 0.

Решение: Для случая взаимозависимых, не равновероятных элементов энтропия равна:

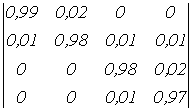

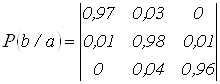

Пример 2. Определить энтропию источника сообщений, если вероят-ности появлений символов на входе приемника, равны: P(b1)=0,1; P(b2)=0,3; P(b3)=0,4, P(b4)=0,2 а канальная матрица имеет вид:

P(a/b)= .

.

Сумма вероятности при одноименных условиях равна![]()

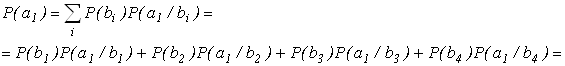

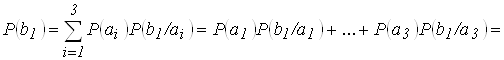

Решение: Определим энтропию источника

.

.

= 0,1×0,99+0,3×0,2+0,4×0=0,105;

![]() = 0,1×0,01+0,3×0,98+0,4×0,01+0, ×2×0,01=0,301;

= 0,1×0,01+0,3×0,98+0,4×0,01+0, ×2×0,01=0,301;

![]() 0,1×0+0,3×0+0,4×0,98+0,2×0,02=0,396;

0,1×0+0,3×0+0,4×0,98+0,2×0,02=0,396;

![]() 0,1×0+0,3×0+0,4×0,01+0,2×0,97=0,198;

0,1×0+0,3×0+0,4×0,01+0,2×0,97=0,198;

Проверка:

![]() 0,105+0,301+0,396+0,198=1.

0,105+0,301+0,396+0,198=1.

При этом энтропия источника равна:

H(A)=-(0,105×log 0,105+0,301×log 0,301+0,396×log 0,396+0,198×log 0,198)=1,856 бит/симв.

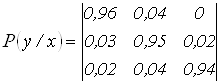

Пример 3. Определить энтропию источника и условную энтропию сообщений, передаваемых по каналу связи, и состоящих из равновероятных символов, если влияние помех в канале описывается матрицей:

.

.

Решение: Для равновероятных символов в сообщении энтропия источника сообщений равна:

![]() бит/симв.

бит/симв.

Полная условная энтропия равна:

![]()

![]()

=![]()

![]()

бит/симв.

Пример 4. Определить энтропию приемника сообщений, если вероятности появления символов a1, a2 и a3 на входе источника сообщений равны P(a1)=0,5; P(a2)=0,3 и P(a3)=0,2, а канальная матрица имеет вид:

,

,

Решение: Энтропия приемника равна:

![]() .

.

Вероятности появления символов на входе приемника

![]() ;

;

![]() ;

;

![]() .

.

Проверка:

![]() .

.

При этом:

Похожие работы

... — В (дождь) и (отсутствие осадков); соответствующие таблицы вероятностей имеют вид: Опыт β1 исходы В вероятн. 0,4 0,6 Опыт β2 исходы В вероятн. 0,8 0,2 Следовательно, энтропии опытов β1 и β2 равны Н (β1 ) = -0,4 log 0,4 — 0,6 log 0,6 0,97 бита, Н (β2) = - 0,8 log 0,8 - 0,2 log 0,2 0,72 бита. Пусть ...

... порядок чередования букв формируется согласно правилам, заданным верхними иерархическими уровнями текста, то есть не «снизу вверх», а «сверху вниз». Что же касается используемой теорией информации вероятностной функции энтропии, то она может быть использована в качестве точного математического инструмента только на нижних уровнях иерархии текста, поскольку только на этих уровнях удается найти ...

стемы. Содержание Нормативные ссылки Введение 1 Расчет информационных характеристик источников дискретных сообщений 2 Расчет информационных характеристик дискретного канала 3 Согласование дискретного источника с дискретным каналом 4 Дискретизация и квантование Заключение Нормативные ссылки В настоящем отчете использованы ссылки на следующие стандарты: - ГОСТ 1.5 – 93 ...

... именно метод скользящего экзамена или некоторые его вариации. Стоит отметить, что эффективность статистических методов классификации сейсмических сигналов также проверяется методом скользящего экзамена. Таким образом, применяя его для тестирования нейросетевого подхода, можно корректно сравнить результаты экспериментов с возможностями стандартных методов. 7. Программная реализация. При ...

0 комментариев