Навигация

Выбор начальных значений весов

1. выбор начальных значений весов.

Так как в конце обучения вектора весов будут располагаться на единичной окружности, то в начале их также желательно отнормировать на 1.00. В моей модели вектора весов выбираются случайным образом на окружности единичного радиуса (рис. 6.1).

2. использование всех нейронов.

Если весовой вектор окажется далеко от области входных сигналов, он никогда не даст наилучшего соответствия, всегда будет иметь нулевой выход, следовательно, не будет корректироваться и окажется бесполезным. Оставшихся же нейронов может не хватить для разделения входного пространства сигналов на классы. Для решения этой проблемы предлагается много алгоритмов ([1],[8]). в моей работе применяется правило «желания работать»: если какой либо нейрон долго не находится в активном состоянии, он повышает веса связей до тех пор, пока не станет активным и не начнет подвергаться обучению. Этот метод позволяет также решить проблему тонкой классификации: если образуется группа входных сигналов, расположенных близко друг к другу, с этой группой ассоциируется и большое число нейронов Кохонена, которые разбивают её на классы (рис. 6.2). Правило «желания работать» записывается в следующей форме:

wн=wc + wс 1 (1 - a), (8)

где wн - новое значение веса,

wс – старое значение,

1 - скорость модификации,

a – активность нейрона.

Чем меньше активность нейрона, тем больше увеличиваются веса связей.

Выбор коэффициента 1 определяется следующими соображениями: постоянный рост весов нейронов по правилу (8) компенсируется правилом (6) (активные нейроны стремятся снова вернуться на гиперсферу единичного радиуса), причем за одну итерацию нейросети увеличат свой вес практически все нейроны, а уменьшит только один активный нейрон или нейронный ансамбль. В связи с этим коэффициент 1 в (8) необходимо выбирать значительно меньше коэффициента в (6), учитывая при этом число нейронов в слое.

3. неоднородное распределение входных векторов в пространстве сигналов и дефицит нейронов.

Очень часто основная часть входных векторов не распределена равномерно по всей поверхности гиперсферы, а сосредоточена в некоторых небольших областях. При этом лишь небольшое количество весовых векторов будет способно выделить входные вектора, и в этих областях возникнет дефицит нейронов, тогда как в областях, где плотность сигнала намного ниже, число нейронов окажется избыточным.

Для решения этой проблемы можно использовать правило «нахождения центра масс», т.е. небольшое стремление ВСЕХ весовых векторов на начальном этапе обучения к входным векторам. В результате в местах с большой плотностью входного сигнала окажется и много весовых векторов. Это правило записывается так:

wн = wс + 2(x – wс). (9)

где wн - новое значение веса,

wс – старое значение,

2 - скорость модификации,

x – входной вектор

Это правило хорошо работает, если нейроны сгруппированы в одном месте. Если же существует несколько групп нейронов, то это правило не дает нужного результата.

Ещё одно решение – использовать «отжиг» весовых векторов. В нашем случае он может быть реализован как добавление небольшого шума при модификации весов, что позволит им перемещаться по поверхности гиперсферы. При обучении уровень шума постепенно понижается, и весовые вектора собираются в местах наибольшей плотности сигнала.

Недостаток этого правила – очень медленное обучение. Если в двумерном пространстве нейроны «находили» входные вектора более-менее успешно, то в многомерном пространстве вероятность этого события существенно снижается.

Самым эффективным решением оказалось более точное моделирование механизма латерального торможения. Как и раньше, находится нейрон с максимальной активностью. Затем искусственно при помощи латеральных связей устанавливается активность окружающих его нейронов по правилу (10):

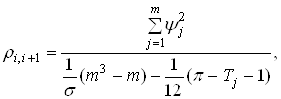

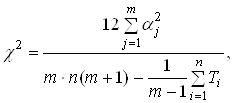

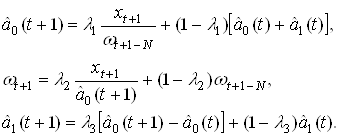

(10)

(10)

aj – активность нейрона

i - выигравший нейрон

j – индекс нейрона

![]() - определяет радиус действия латеральных связей, уменьшается в процессе обучения

- определяет радиус действия латеральных связей, уменьшается в процессе обучения

При этом предполагается, что все нейроны имеют определенную позицию по отношению к другим нейронам. Это топологическое отношение одномерно и линейно, позиция каждого нейрона определяется его индексом. Правило (10) говорит о том, что возбуждается не один нейрон, а группа топологически близких нейронов. В результате обучения образуется упорядоченная одномерная карта признаков. Упорядоченность означает, что ближайшие два нейрона в ней соответствуют двум ближайшим векторам в пространстве сигнала, но не наоборот (так как невозможно непрерывно отобразить многомерное пространство на одномерное). Сначала радиус действия латеральных связей достаточно большой, и в обучении участвуют практически все нейроны. При этом они находят «центр масс» всей обучающей выборки. В процессе обучения коэффициент ![]() уменьшается, нейроны разделяются на группы, соответствующие локальным центрам масс. В конце концов радиус латеральных связей снижается настолько, что нейроны функционируют независимо друг от друга и могут разделять очень близкие вектора.

уменьшается, нейроны разделяются на группы, соответствующие локальным центрам масс. В конце концов радиус латеральных связей снижается настолько, что нейроны функционируют независимо друг от друга и могут разделять очень близкие вектора.

6. Применение

Разрабатываемая система может применяться как инструмент для проведения исследований в данной предметной области, для демонстрации принципов работы нейросетей и модели синтеза речи.

Список использованных источников

1. Ф. Уоссермен «Нейрокомпьютерная техника: Теория и практика». Перевод на русский язык Ю. А. Зуев, В. А. Точенов, 1992.

2. Винцюк Т.К. «Анализ, распознавание и интерпретация речевых сигналов.» -Киев: Наук. думка, 1987. -262 с.

3. Speech Analysis FAQ - http://svr-www.eng.cam.ac.uk/~ajr/SA95/SpeechAnalysis.html

4. Л.В. Бондарко «Звуковой строй современного русского языка» -М.: Просвещение, 1997. –175 с.

5. Э.М.Куссуль «Ассоциативные нейроподобные структуры» -Киев, Наукова думка, 1990

6. Н.М. Амосов и др. «Нейрокомпьютеры и интеллектуальные роботы» -Киев: Наукова думка, 1991

7. Г. Нуссбаумер «Быстрое преобразование Фурье и алгоритмы вычисления сверток». Перевод с англ. – М.: Радио и связь, 1985. –248 с.

8. А.А. Ежов, С.А. Шумский “НЕЙРОКОМПЬЮТИНГ и его приложения в экономике”, - МИФИ, 1998

Похожие работы

... задач за счет применения средств автоматизации, снижение затрат за счет сокращения штата сотрудников, привлекаемых к делопроизводству, поиску и сортировке управленческой документации за счет внедрения электронного документооборота и т.д.) Результаты второго рода могут быть измерены с помощью экономических показателей, находящихся в бухгалтерской отчетности. Доход третьего рода получают за счет ...

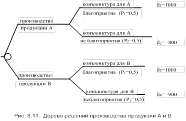

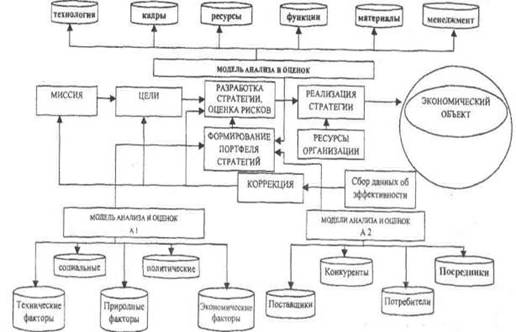

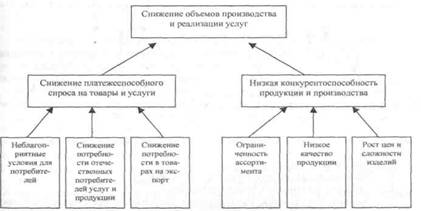

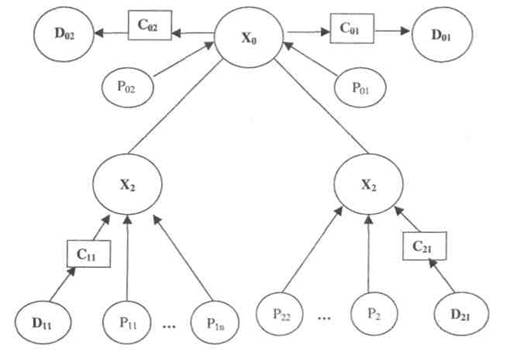

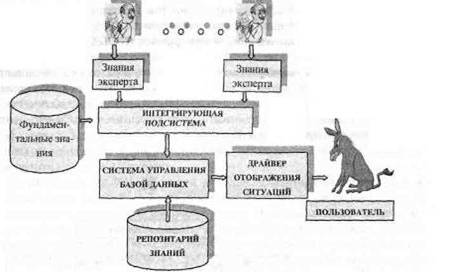

... уровня. В общем случае в качестве вариантов решений можно использовать классы стратегий, предлагаемых в экономической литературе. 16. Особенности проектирования интеллектуальной экономической информационной системы Проектирование ИИС начинается с обследования предметной области. Современные технологии такого обследования базируются на концепции и программных средствах реинжиниринга бизнес- ...

... МП к некритическому экстраполированию результата считается его слабостью. Сети РБФ более чувствительны к «проклятию размерности» и испытывают значительные трудности, когда число входов велико. 5. МОДЕЛИРОВАНИЕ НЕЙРОННЫХ СЕТЕЙ ДЛЯ ПРОГНОЗИРОВАНИЯ СТОИМОСТИ НЕДВИЖИМОСТИ 5.1 Особенности нейросетевого прогнозирования в задаче оценки стоимости недвижимости Использование нейронных сетей можно ...

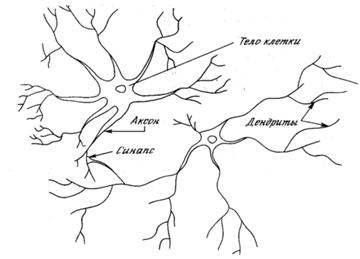

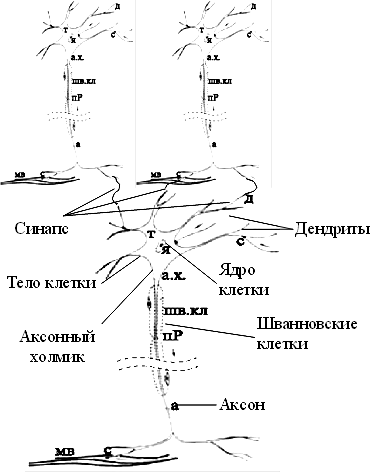

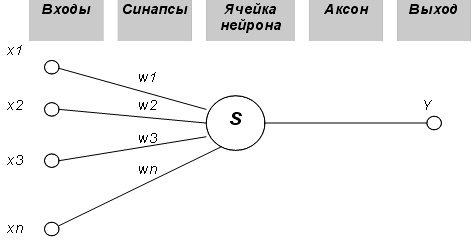

... информацию, находить в ней закономерности, производить прогнозирование и т.д. В этой области приложений самым лучшим образом зарекомендовали себя так называемые нейронные сети – самообучающиеся системы, имитирующие деятельность человеческого мозга. Область науки, занимающаяся построением и исследованием нейронных сетей, находится на стыке нейробиологии, математики, электроники и программирования ...

0 комментариев