Системный анализ и проект

Конспект - черновой (лекторский) вариант, в некоторых разделах носит характер иллюстративной поддержки

Существуют две очень близкие точки зрения на то, что есть СА –

Первая - это механизм раскрытия неопределенностей и формализации решения любой проблемы – эта точка зрения работает, как источник новых научных направлений, выросших из системного анализа - таких как "Исследование операций", "Теория графов", "Сеттевое планирование" и прочее, прочее, прочее.

Вторая – это более общий вгляд, обобщение проблемы (задачи ) моделирования . Как следствие - понадобилась формализация этого более общего вгляда на моделирование – как на процесс исследования объекта и всех связанных с этим исследованием идей, проблем, вопросов, - что-бы

1.-структурировать последовательность решения задач при моделировании

2.-выделить общие механизмы в различных задачах моделирования и

3.-разработать специальные подходы в особо интересных для практики задачах

Результат структуризации вопросов связанных с моделированием может быть представлен, как упорядоченный перечень задач, процедур которые стоят между неформальной постановкой проблемы и окончательным математическим ее решением .

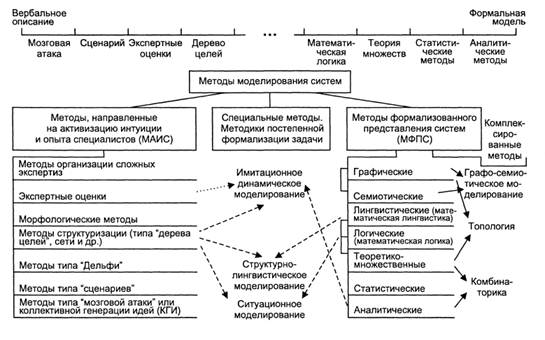

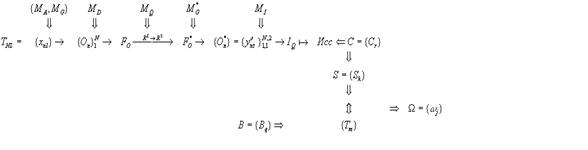

Сказанное можно итожить в виде таблицы задач, связанных с моделированием , таким образом:

Структура задач процесса моделирования

наиб просто - это задачи Анализа - и - Синтеза:

Анализ-Синтез = ![]() Анализ Объекта- Синтез Модели - Анализ Модели =

Анализ Объекта- Синтез Модели - Анализ Модели = ![]()

= Декомпозиция Объекта - ПричинноСледственный Анализ - Синтез Модели - Анализ Модели

таблица 1

|

1.Декомпозиция объекта |

2.Прич.Следств.Анал. |

3. Синтез модели |

4.Анализ модели |

Содержание каждого раздела таблицы мы рассм позже - сейчас общая х-ка

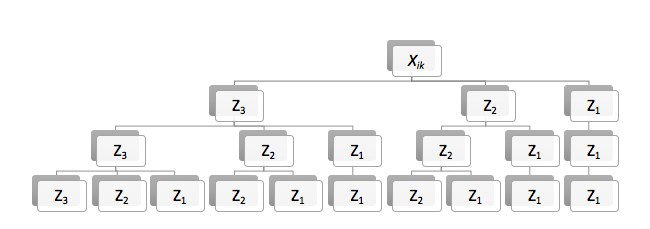

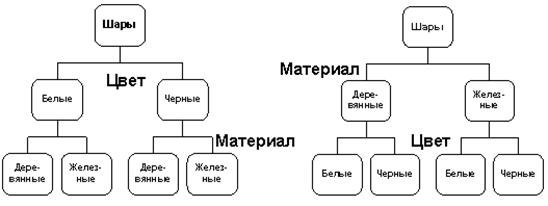

1-вый раздел - это вопросы декомпозиции (умозрительного расчленения) анализа и исследования объекта и его струкуры непосредственно имея дело с объектом и в результате чего мы должны получить

1.- моделеобразующие гипотезы об объекте и приближенное укрупненное представление о его структуре

2.- определится с структурными кирпичиками изучаемой системы (переменные состояния, управления,если оно имеется, шумами в системе)

3. Получить возможные характеристики и наборы экспериментальных данных которые мы в дисциплине "Статистическое моделирование" считаем заранее предоставленными в виде таблиц или матриц ОБЪЕКТ-СВОЙСТВА.

Однако после решения задач 1-го раздела еще невозможно приступать к собственно моделированию. Мы об этом говорили ранее, когда отмечали недостатки методологии статистического моделирования, которое моделирует лишь исходя из факта силы связи но никак не анализирует направления связи между предполагаемыми входными и выходными переменными. Предварительный причинно-следстенный анализ даст ответ какие переменные имеют право оказатся в правых частях моделируемых соотношений типа у=f(x)

итак

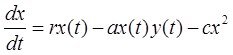

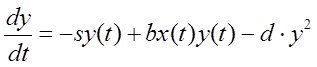

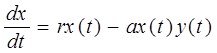

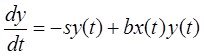

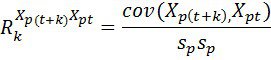

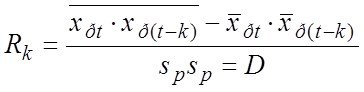

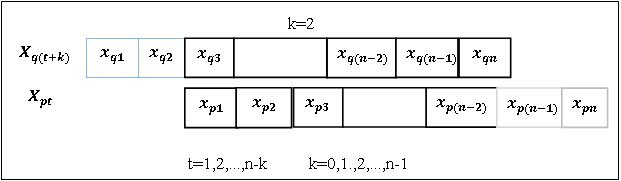

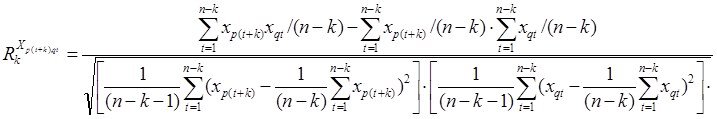

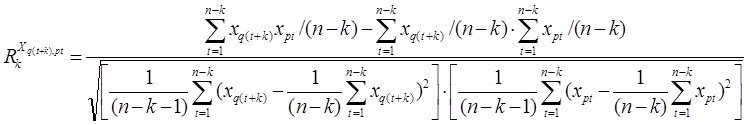

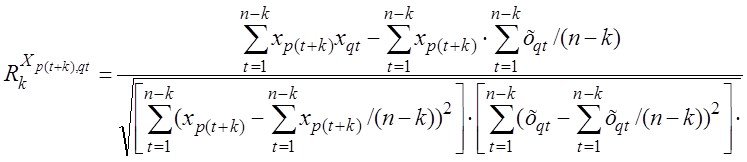

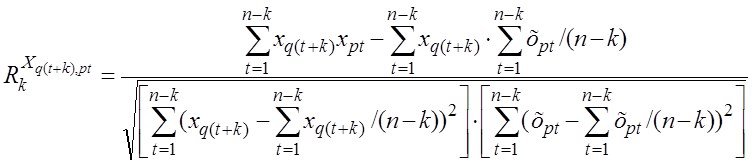

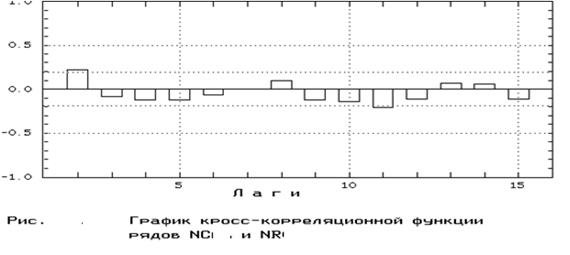

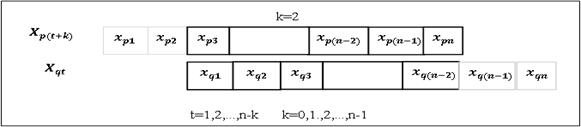

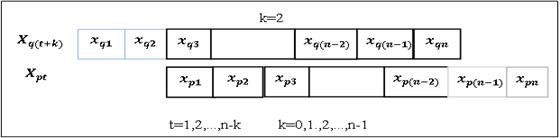

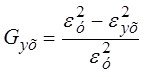

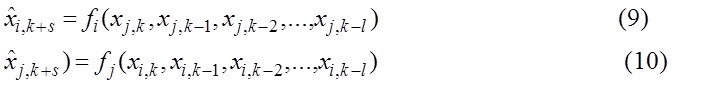

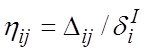

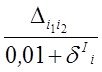

2-й раздел посвящен решению вопросов ПСА - методам определения направления ПСС ![]() ,

,![]() во всех парах доступных переменных (процессах)

во всех парах доступных переменных (процессах) ![]()

![]()

![]()

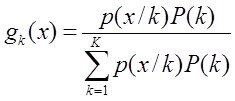

![]() . дающим возможность приступить к задачам непосредственно моделирования (3-ий столбец-раздел задач). Кроме того мы рассмотрим и применение ПСА непосредственно к решению некоторых задач моделирования и классификации (мед диагностики)

. дающим возможность приступить к задачам непосредственно моделирования (3-ий столбец-раздел задач). Кроме того мы рассмотрим и применение ПСА непосредственно к решению некоторых задач моделирования и классификации (мед диагностики)

- составление матриц ПСС и сравнение их в классах

к курсовому - пост2 - признаки процессы.

3-й раздел - собственно различные задачи моделирования свойств, объектов и систем. Здесь 3 подраздела - моделирование свойств данных, моднлирование систем и моделирование взаимодействия систем. Мы здесь рассмотрим современные подходы к моделированию экспериментальным данным и некоторые новые методы решения задач классификации и диагностики в усложненной постановке - для объектов заданных множеством измерений

(коротко суть проблемы)

А. Технология для детерминированной постановки:

- объекты заданы подматрицами объект-свойства Х,Y. Построив структуру у=f(a1х1,a2х2,...,amхm) - переходим для классификации в пространство параметров a1,a2,...,am

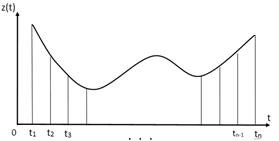

В. Технологии для задачи классификации объектов, характеризующихся процессами (реализациями процессов)

Для процессов, описывающих объекты классификации, могут быть характерны

1. Детерминированные по времени составляющие

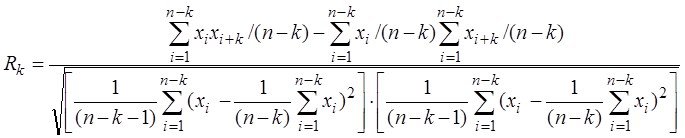

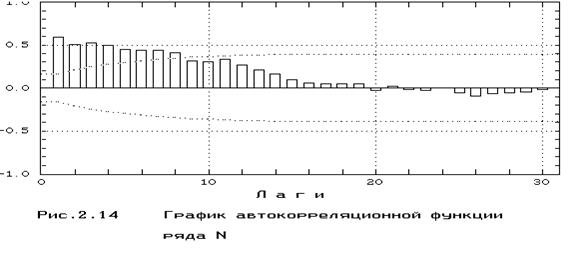

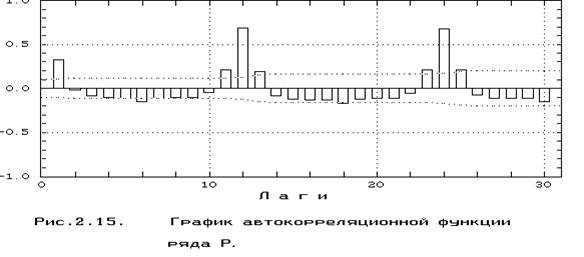

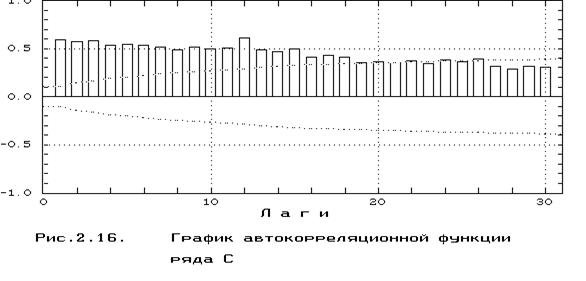

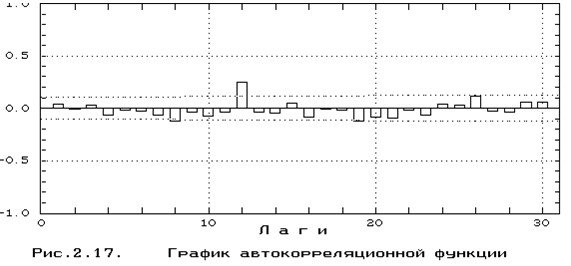

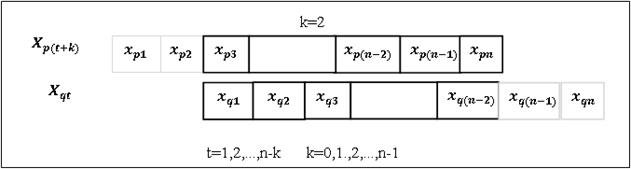

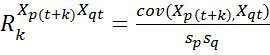

2. Детерминированные по запаздываниям составляющие (детерминированные по структуре и параметрам автокорреляционных и взаимокорреляционных составляющих)

3.Случайные составляющие

4. Взаимные статистические причинно-следственные связи между процессами.

Тогда возможно использовать для формирования пространства параметров классификации следующие технологии

В1). Детерминированный случай =параметризация составляющей процесса/ов сводится к п.А

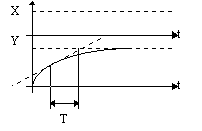

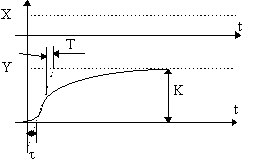

пример.- разгонные х-ки двигателей w=F(а,t) при подаче 220в на двигатель

В2.) Построение автокорреляционных моделей для каждого процесса и перевод задачи классификации в пространство параметров этих автокорреляционных моделей (а1 1,а1 2...а1 к1, а2 1,а2 2,...а2 к2, ..., аm 1,am 2,...,amkm)

В3) Построение взаимокорреляционных моделей для моделирования ведущего/их процесса/ов объектов и перевод задачи классификации в пространство параметров этих моделей

В4 ) Вычисление случайных составляющих процессов и определение их распределений = маргинальных и совместных распределений и их параметров

в4.1)- Дополнителные признаки - параметры маргинальных и совм распределений

в4.2) - Классификация по распределениям параметров распределений (маргинальных и совместных) случайных составляющих исходных процессов -типа класс метод (макс правдоподобия) для распределений параметров распределений (так как для каждого объекта имеем целые распределения - поэтому далее получаем для множества объектов -- распределения параметров распределений)

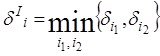

В5 ) Определение матриц статистических причинно-следственных связей (ПСА) и классификация объектов по мере близости этих матриц в классах

раздел-столбец 4 таблицы- изучение основных свойств полученных моделей с тем, что-бы убедится в ее адекватности нашим ожиданиям

Мы вернемся еще к рассмотрению задач разделов табл. 1.

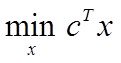

Пока же начнем с сердца системного анализа - собственно моделирования, и моделирования по экспериментальным данным. Это графа 3 таблицы - здесь рассмотрим задачи параметрического и структурно-параметрического синтеза для решения задачи построения многомерной регрессии данных

МОДЕЛИРОВАНИЕ

Современное моделирование (в том числе аналитическое) принято отслеживать от группы ученых связанных с Ньютоном, создавшего теорию бесконечно малых – Теорию Диференциального и Интегрального исчисления. Это удивительное прозрение практически впервые породило аналит ические математические модели в точности соотв-щие реальным физическим процессам.

Он выдвинул гениальную по простоте и адекватности идею что значительное количество физических моделей макромира увязывают в своих взаимоотношениях линейные перемещения с их скоростями,ускорениями и тд и создал строгий аппарат обращения с данными величинами и уравнениями связвывающими эти величины.

С помощью этого аппарата была решена грандиозная задача - задача моделирования движения тел небесной механики.

Паралельно эта задача породила к жизни сопутствующие направления исследований - теорию вероятности (ЛАГРАНЖ, МУАВР, БАЙЕС).

Конечно ТВ имеет свои родные корни, связанные с изучением случайности, но вычислительные, практические аспекты ТВ стимулировала родственная «небесной механике» задачка из теории измерений. Именно ниже указанная задача стала первой сформулированной задачей статистического моделирования.

Надо было наиболее точно определить начальные условия для реш задачи Неб Мех – то есть определить наиболее точное положение звезд на небосклоне по неоднократным их измерениям..

Таким образом в 1800-тых годах - Лаплас, Гаусс и Лежандр, каждый из которых в то время работал над теорией движения небесных тел и не мог обойти проблемы теории измерений предложили свои варианты решения такой задачи. Сначала о Лапласе.

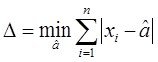

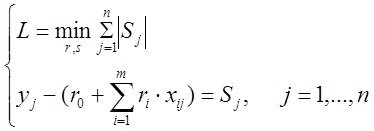

Лапласом было предложено оценивать неизвестное значение измеряемой величины ![]() по его повторным измерениям

по его повторным измерениям ![]() как такую величину

как такую величину ![]() , которая обеспечивает минимум ф-лу

, которая обеспечивает минимум ф-лу  (*)

(*)

Оказалось, что такое значение ![]() соответствует нахождению выборочной эмпирической медианы - то есть такому числу

соответствует нахождению выборочной эмпирической медианы - то есть такому числу ![]()

, справа и слева от которого находится одинаковое количество измерений.

, справа и слева от которого находится одинаковое количество измерений.

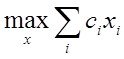

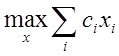

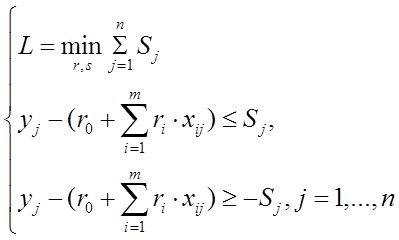

Позже, было показано что задача минимизации суммы модулей отклонений решаеться линейным программированием. О ЛП?

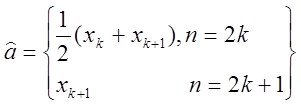

Но в то время ученому сообществу более простой и технологичной показалась идея двух других французов –Гаусса и Лежандра которые для тех же условий задачи предложили минимизировать ф-нал

(**)

(**)

и предложили технологию Метода Наименьших Квадратов которую мы в общих чертах уже представляем.

Ниже немного обобщим взгляд на эту технологию моделирования

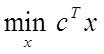

Задачи моделирования по экпериментальным данным

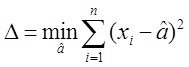

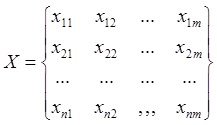

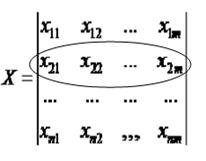

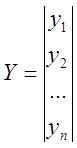

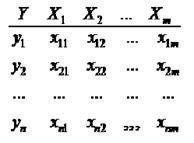

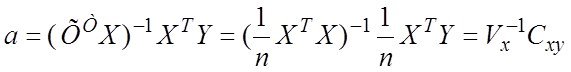

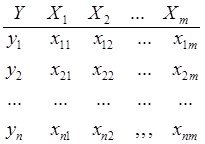

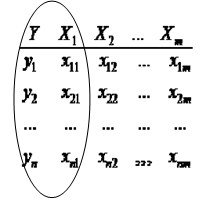

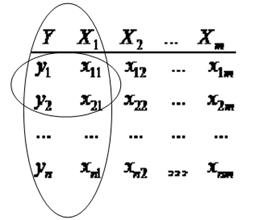

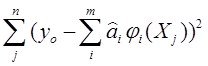

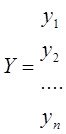

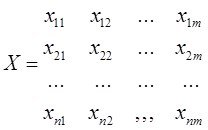

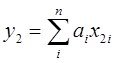

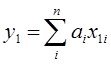

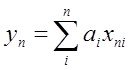

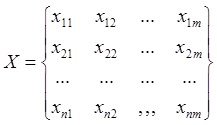

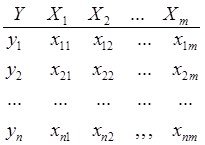

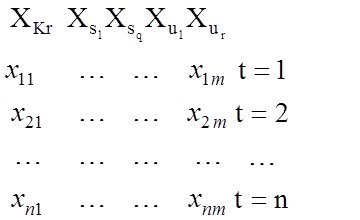

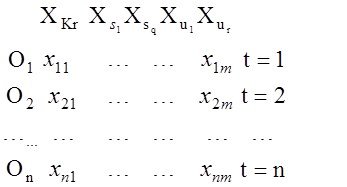

Исх.данные задачи моделивания - , здесь

, здесь  – вектор выхода, Х1,….,Хm – входы¸ m= кол. перем., n-кол точек данных

– вектор выхода, Х1,….,Хm – входы¸ m= кол. перем., n-кол точек данных  - матрица значений входных переменных

- матрица значений входных переменных

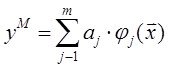

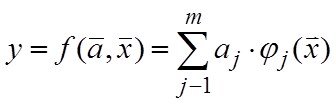

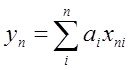

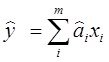

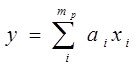

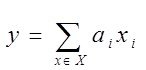

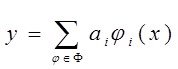

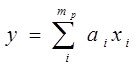

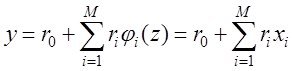

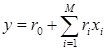

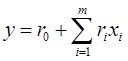

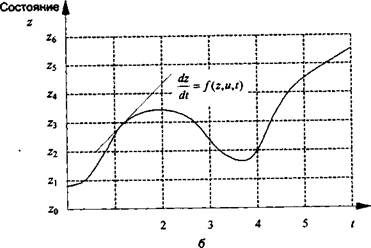

Модель в самом общем виде предполагем вида ![]()

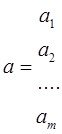

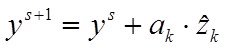

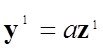

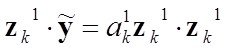

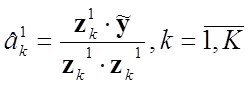

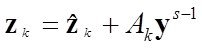

Делаем шаг упрощения задачи – предполагаем наличие в структуре переменных быстрых - х и медленных - а , то есть

![]() и назовем медленые переменые

и назовем медленые переменые

а – параметрами модели

При моделировании выделяют две задачи

– параметрический и структурный синтез модели ![]()

То есть необходимо найти структуру![]() и параметры модели

и параметры модели ![]() .

.

Однако на практике применяються несколько другие две задачи:

1.расчета вектора коэфф ![]() при заданной структуре модели

при заданной структуре модели ![]() и

и

2. более практическая задача, когда ищем и структуру ![]() и параметры модели

и параметры модели![]()

По поводу различных структур –

Пример – какие ниже стуктуры одинаковые а какие разные

1. у = з-х+х3 2. у= 3х-х2 3.у= 3+х2+х3 4. у=3х-х3

При фиксированой структуре эффективность найденных параметров модели ![]() оценивают по разному

оценивают по разному

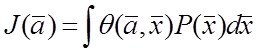

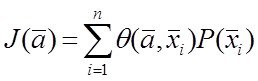

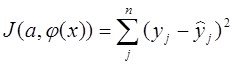

– один из вариантов - функционалом

или

или  (*)

(*)

где ![]() - функция адекватности модели , а

- функция адекватности модели , а ![]() - плотность распределения.

- плотность распределения.

С адекватностью понятно –в дискретном случае это может быть “обьясненная дисперсия”, коэфф детерминации (мах) или отн. норм.среднекв.ошибка (мин)

Ну а причем здесь плотность распределения ![]() – а?

– а?

![]() играет роль весовых коэффициентов в ф-ле, учитывающих частоту попадания объекта в точку i (облaсть i ).

играет роль весовых коэффициентов в ф-ле, учитывающих частоту попадания объекта в точку i (облaсть i ).

Обычно для построения ![]()

-(обращаю внимание на то, что

![]() - вектор и

- вектор и ![]() - многомерная плотность)

- многомерная плотность)

нужно очень много данных,

Когда же мы имеем такую роскошную

возможность иметь столько данных? –

когда имеем длинный сигнал (временной ряд) ,например, в медицинских приборах, и вообще работа в реале с накоплением данных об объекте.

Если наша задача – построить прогнозирующий фильтр (прогнозирующую модель)– тогда для Р(х) учитывают данные всей доступной кривой, а прогнозирующую модель расчитывают используя ограниченный скользящий участок методами стохастической аппроксимации, - то есть взвешивая невязки в соответствие с плотностью.

Когда нет доступа к такому большому количествку данных то

чаще обходятся без ![]() , считая в (*), что

, считая в (*), что ![]() неизвестна, вернее принимая

неизвестна, вернее принимая ![]() , считая все слагаемые равноправными таким образом принимая что плотность равномерна.

, считая все слагаемые равноправными таким образом принимая что плотность равномерна.

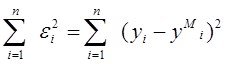

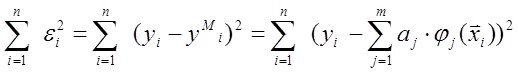

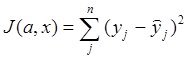

Если теперь функционал качества задачи моделирования выбрать в виде суммы квадратичных. невязок

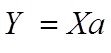

J (а)= и при виде моделии

и при виде моделии

придем к для поиска параметров а к обычному механизму МНК

Но будем помнить что принцип взвешивания невязок в МНК – важное ответвление РА (называемое взвешенный МНК), и используется он в задачах моделирования при непрерывном поступлении новых данных в систему – это моделироваие сигналов, временных рядов под. которые необходимо подстроить их модели для дальнейшей обработки - например для прогноза ряда, или очистки сигнала от шума и т.д.

Вернемся к обычному МНК

Задача параметрического синтеза

Постановку задачи для поиска коэффициентов по методу наименьших квадратов (МНК) при фиксированной структуре модели:

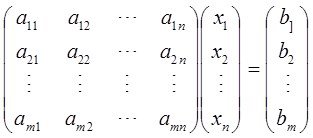

Задана матрица значений аргументов

Задана матрица значений аргументов

(**) и вектор выхода  ,

,

1.Введем предположеие – достаточно сильное и тем неприятное - – предположим что модель линейна по параметрам

Предположение вводится в основном потому что мы умеем решать такие задачи, а не потому что это как то обосновано, Здесь есть нечто общее с тем что « будем искать потеряное под.фонарем, потому что там видно а не потому что там потеряли».

2 Наконец предполагаем что нам известна структура  то есть сейчас мы занимаемся задачей параметрического синтеза

то есть сейчас мы занимаемся задачей параметрического синтеза

Если тепер, как мы говорили выше, функционал качества задачи моделирования выбрать в виде сумм квадратичных. невязок

J(у) = (**)

(**)

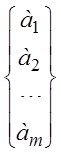

то для определения вектора параметров![]() достаточно решить систему линейных уравнений

достаточно решить систему линейных уравнений  (*О*)

(*О*)

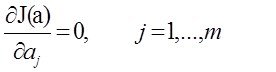

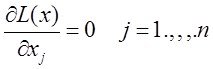

Действительно вспомним условия экстремума функций, тогда понятно откуда получена система (*О *)

Обратим внимание что систему получим линейную отностельно аj

Все достаточно просто.Решая эту систему получаем наилучший вектор парамеров а который дает минимум функционалу (**)

Таким образом решается задача параметрического синтеза.

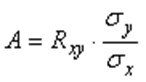

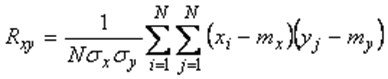

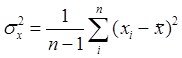

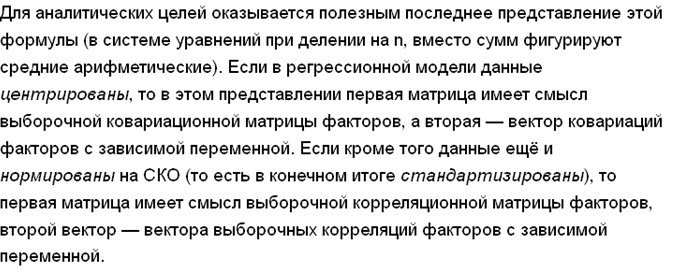

Для частного случая одномерной регресии У=ах+в, его решение МНК можно получить как простые формулы для ![]() , где

, где ![]() - коэффициент регрессии,

- коэффициент регрессии,  ,

,  -коэффициент корреляции х,у,

-коэффициент корреляции х,у,

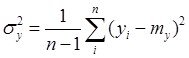

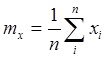

![]() и

и ![]() ,

,![]() выборочные среднеквадратические отклонения и выборочные математические ожидания случайных величин

выборочные среднеквадратические отклонения и выборочные математические ожидания случайных величин ![]() и

и ![]()

,

,  ,

,  ,

,

№2

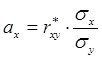

Но если регрессия не одномерная, то никто в наше время в расчетах не записывает функционал в скалярном виде, не берут производные , не составляют системы скалярных уравнений и тд. Для решения задачи поиска параметров регрессии пользуются матричные представления данных и операций. Я пользовался выше скалярной записью, только затем, что-бы в начале было проще показать смысл процедур поиска параметров.

Упрощенный вывод формулы МНК в матричном виде

Упрощенный вывод формулы МНК в матричном виде

Напомним

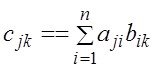

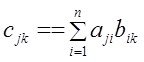

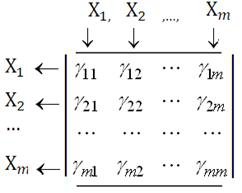

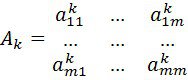

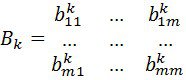

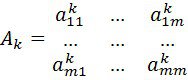

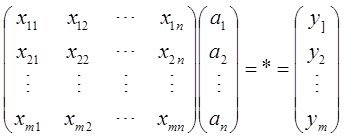

1.–Для умножения матриц А и В – А*В=С

–то есть получения элемента ![]() необходимо взять в А (первой матрице) j-тую строку

необходимо взять в А (первой матрице) j-тую строку ![]() и в В (второй матрице) k-тый столбец

и в В (второй матрице) k-тый столбец ![]() и образовать скаляное поизведение

и образовать скаляное поизведение  .

.

2. Траспонирование

2. Траспонирование

– столбцы делает строками, строки столбцами

(в квадратной матрице – просто зеркально отображаем относительно гл диагонали)

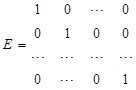

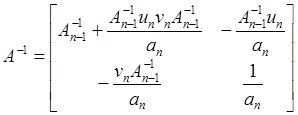

3.Обратная матрица А-1 матрицы А это такая матрица для которой выполняется А-1*А=Е, где

3.Обратная матрица А-1 матрицы А это такая матрица для которой выполняется А-1*А=Е, где  единичная матрица

единичная матрица

Итак имеем матрицу Х и вектор выхода У

необходимо построить модель линейной структуры

необходимо построить модель линейной структуры

Уже понимаем почему пишем Ха а не аХ

При этом необходимо максимально приблизить с помощью вектора а матричное соотношение (***)

При этом необходимо максимально приблизить с помощью вектора а матричное соотношение (***)

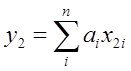

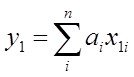

В скалярном виде это соответствует наилучшему приближению

в первой точке

в первой точке

………… в n-ой точке -  (***)

(***)

Далее будем исходить из (***) как из равенства и будем из него искать а. Более обосновано вывод проведем немного позже. Итак имеем

Далее будем исходить из (***) как из равенства и будем из него искать а. Более обосновано вывод проведем немного позже. Итак имеем

![]() Для того что-бы освободить а (умножить то что при а на обратную Х матрицу и получить в результате Е – ед матрицу ) надо чтобы при а стояла квадратная матрица.

Для того что-бы освободить а (умножить то что при а на обратную Х матрицу и получить в результате Е – ед матрицу ) надо чтобы при а стояла квадратная матрица.

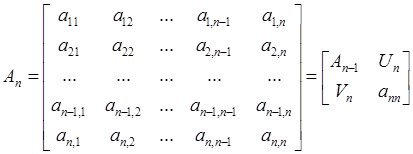

Умножим слева и справа на ХТ получим Теперь поскольку ХТХ – квадратная – можем ее умножить на обратную -

слева и справа на (Х ХТ)-1

и окончательно имеем для а

![]() и для модели

и для модели

Все - И все расчеты проводятся по этой формуле

- в любых инжененых пакетах реализованы матричные операции -

все очень просто (мы поработаем на практике) и

не очень просто в связи с операцией взятия обратной матрицы и понятием плохой обусловленности матрицы.

Что это - плохая обусловленность матрицы:

напомним о так наз. собственных числах матрицы

/А-лЕ/=0 ......для опред Л - решаем степенное уравнение соответствующего порядка напомним на примере 2-го порядка

ПлОбМа возникает когда λmin << λmax.

и численно мера ПОМ выражается их отношением

или близостью к нулю ее детерминанта -

Этот эффект ПОМ обычно набл когда в А одновременно присутствуют очень большие и очень малые числа - тогда при операции нахождения обратной матрицы обусловленность резко ухудшается (очень малые числа деляться на очень большие) и лавинообразно растет погрешность (изза выхода значущих цифр за пределы разрядной сетки ВМ)- решение теряется в эффекте ПлОбМа

Это одна из причин что РА только начинается а не заканчивается на формуле для а. Преодоление ПОМ - различные олгоритмя регуляризаци матрицы А ......желательно с минимальной потерей ее эквивалентности

Другие проблемы больше связаны с задачей структурного синтеза - об этом позже А пока более строгий вывод, который

повторяет логику, изложенную для скалярного вида:

Пусть размерность задачи m перем и n точек

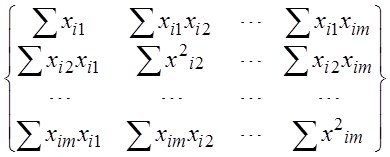

Критерий по которому работает МНК: минимировать сумму квадратов ошибок еi=Уi-(ао+а1х1i+…+аmxmi) модели У=ао+а1х1+…+аmxm в заданных точках. В матричном виде, модель У=Ха должна минимизировать критерий в матричной форме:

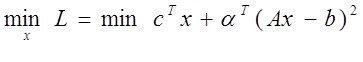

![]()

Дифференцируя эту функцию по вектору параметров и приравняв производные к нулю, получим систему уравнений (в матр. форме)

![]() , отсюда

, отсюда ![]() (** ) и далее решая (**) можем найти вектор а=(хтх)-1хту

(** ) и далее решая (**) можем найти вектор а=(хтх)-1хту

В расшифрованном матричном виде эта система уравнений имеет вид

=

= X и XTX - осн

X и XTX - осн

Где все суммы берутся по количеству точек ![]()

Если в модель включен свободный член то ![]() для всех

для всех ![]() i

i

Это и есть т.н. нормальная система уравнений Xи XTX- осн зол матр мод

Решение этой системы и дает общую формулу МНК-оценок

X и XTX- основные золотые матр мод -матрица объект-свойства и информационная матрица Фишера (при центр Х - ковар матрица)

И так с расчетов параметров на первый взгляд все просто (на самом деле проблема есть с обращением матриц,)

А вот со структурно-параметрическим синтезом так просто не получается

Для понимания в каких условиях и почему классические шаговые алгоритмы многомерной регрессии, к сожалению, не дают ожидаемых наилучших результатов моделирования при структурно-парам. Синтезе. Нам полезно

1. рассмотреть геометрические интерпретации МНК и

2. привести некоторые свойства метода МНК и регрессионных моделей

1 что такое обусл М 2 почему она плоха

Геометрические интерпретации МНК или почему регрессия не алгебра (более корректно -почему регрессионные. уравнения не алгебраические уравнения).Детский вопрос –

если в алгебре из ![]()

![]()

![]()

![]()

![]()

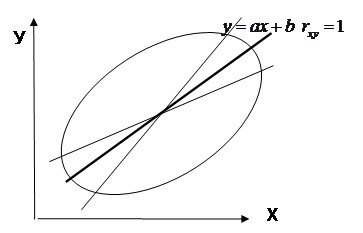

то почему в регрессионных уравнениях из ![]() ,

, ![]()

не следует что ![]() и

и ![]() ?

?

А имеем мы (у вас эти ф-лы есть)

,

, ![]() и

и

![]() где

где ![]() - выборочный коэффициент корреляции

- выборочный коэффициент корреляции

(  - оцен зн. коэфф корр. ур совпадут при одинаковом расбросе

- оцен зн. коэфф корр. ур совпадут при одинаковом расбросе ![]() - это так потому что просто первая формула представит график в осях у-х а вторая х-у )

- это так потому что просто первая формула представит график в осях у-х а вторая х-у )

Для того что бы не формально понять эти результаты (и для других целей) полезны геометрические интерпретации регрессии.

…………..

Напомним, что нам известно

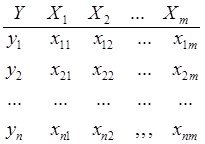

Любая задача моделированмя по экспериментальным данным начинается с данных – таблицы результатов эксперимента или таблицы наблюдений –

здесь m= кол.перем., n-кол точек данных

здесь m= кол.перем., n-кол точек данных

Итак, матрица данных имеет m столбцов и nстрок, соответственно

геометрическую интерпретацию регресии можно получить

в пространстве столбцов или

в пространстве строк

= или что то же самое

в пространстве переменных (оси –переменные) или

в пространстве точек. (оси - номера точек)

Интерпретация в пространстве переменных (столбцов)

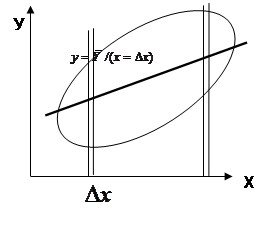

Рассмотрим случай одномерной регрессии – имеем только столбцы У и Х1

Рассмотрим случай одномерной регрессии – имеем только столбцы У и Х1

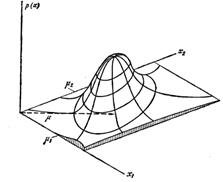

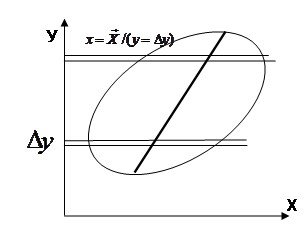

Идея регрессии пришла в математику из теории вероятности. ТВ по сути дала следующее

определение уравнению регресии: регрессия это

матожидание условной вероятности

![]() (1)

(1)

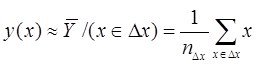

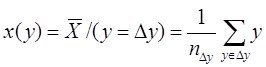

или с учетом,что у нас есть только конечная выборка ![]() , то

, то ![]() ( 2)

( 2)

Теоретически при увеличении выборки ( 2)![]() (1), то есть

(1), то есть

![]() , аналогично для

, аналогично для ![]() - с учетом конечности выборки

- с учетом конечности выборки

![]() ( 2*)

( 2*)

Тогда использовав выборочные оценки мат. ожиданий как формулы для средних значений точек попавших в полосы ![]() и

и ![]() получим приближенные выражения для геометрического построения регрессий

получим приближенные выражения для геометрического построения регрессий

|

Если условные распределения

Если условные распределения ![]() и

и ![]() унимодальны и симметричны то по этим формулам для средних линий в полосах получим в каждом “яйце” точки, принадлежащие линии регрессии. Для каждой линии достаточно построить по 2 точки и мы их проведем.

унимодальны и симметричны то по этим формулам для средних линий в полосах получим в каждом “яйце” точки, принадлежащие линии регрессии. Для каждой линии достаточно построить по 2 точки и мы их проведем.

Обращаю внимание что регрессии у=f(x) и х=f(у) не совпадают ?Они совпадут (центральная линия) – и регр превр в алгебру - когда рассеяние симм отн бисктр и ![]()

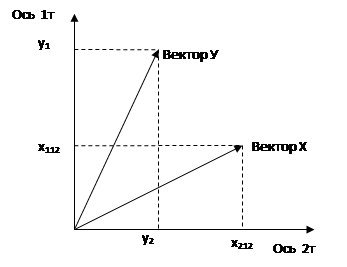

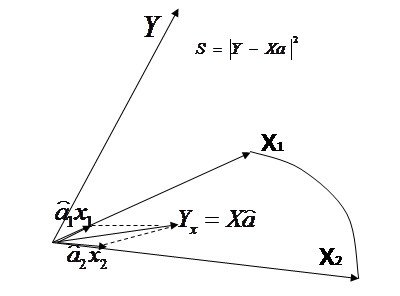

Интерпретация в пространстве точек

Интерпретируем на осях двух точек

и для 2-х векторов - У и Х1

(хотя при осях 2 точек можно и все вектора

изобразить )

Для простоты будем изображать

центрированные варианты векторов

(без своб.члена)

Отложим в пространстве осей 2-х точек (две оси, чтобы возможно. было изобразить геометрическую интепретацию) вектора у и х

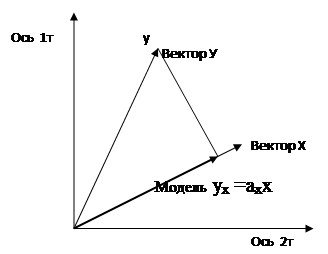

Регрессия МНК это проекция

моделируемого вектора в

плоскость векторов, по которым

моделируем.

А в одномерном случае

- это проекция на тот вектор,

с помощью которого мы

мы моделируем . То есть -

Проектируем вектор у на вектор х и получаем модель у по х:

ух =ахх

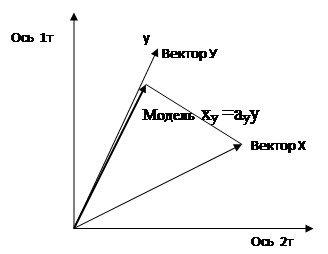

Проектируем вектор х на вектор у и получаем модель х по у: ху =ауу

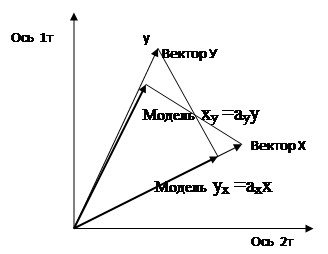

Или на одном рисунке -

Теперь понятно, - поскольку проекции ух и ху – не совпадают, то и уравнения у них разные - из одной модели другая не получится.

А совпадут они - при колинеарности у и х

(что есть геометрический эквивалент коррелируемости ![]() )

)

Регрессия МНК это проекция моделируемого вектора в плоскость векторов, по которым моделируем ----------в плоск 2-х иксов

Регрессия МНК это проекция моделируемого вектора в плоскость векторов, по которым моделируем ----------в плоск 2-х иксов

2 ?? === ===========================

Свойство проективности МНК

( вывод осн ф-ла МНК, используя теперь свойство проективности)

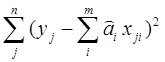

1. Напомним, что применяя МНК для регресии  (1)

(1)

мы оцениваем параметры регресии ![]() с точки зрения минимизации функционала

с точки зрения минимизации функционала ![]() :

:  =

= (1*)

(1*)

Здесь ![]() и

и ![]() наблюдаемые и модельные значения соответственно.

наблюдаемые и модельные значения соответственно.

Напомним что дальнейшие результаты будут такие же, если мы вместо (1) будем рассматривать модель более общую модель  (2) и ф-нал

(2) и ф-нал  =

= (2*)

(2*)

Результаты будут верны с точностью до переобозначения.

Поэтому, рассуждая в дальнейшем об (1) что формально проще, имеем далее в виду и (2) то есть модель нелинейную по аргументам регрессии.

2. Описывая данные задачи регрессии в виде таблиц естественно и выводить основные результаты в матричном виде (что бы не выделять отдельно своб член - ниже для упрощения записи - ![]() - ед.вектор) поэтому введем обозначения:

- ед.вектор) поэтому введем обозначения:

вектор  матрица

матрица  и вектор

и вектор

Напомним осн. правила матричных операций

1.–Умножения – А*В=С -  то есть для получениия jk-того элемента С - в А берут j-тую строку, в В k-тый столбец и их скалярно перемножают.

то есть для получениия jk-того элемента С - в А берут j-тую строку, в В k-тый столбец и их скалярно перемножают.

2. Траспонирование

2. Траспонирование

– столбцы делает строками, строки столбцами

(в квадратной матрице – просто зеркально

отображаем относительно гл диагонали)

кроме того: (АВ)Т=ВТ АТ и следствие (АВС)Т=СТВТАТ

3.Обратная матрица А-1 матрицы А это такая матрицадля которой выполняется

![]() А-1*А=Е, где единичная матрица

А-1*А=Е, где единичная матрица

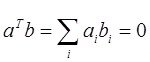

4.Свойство ортогональности векторов а и в:

Наше требование к регресии - выполнение равенств - что должно бы выполняться - в первой точке

Наше требование к регресии - выполнение равенств - что должно бы выполняться - в первой точке

………… в n-ой точке -  (*)

(*)

На самом деле выполнить их невозможно ввиду предположения ![]()

Эти условия (требования) (*) в матричном виде можно записать как

![]() (именно в таком порядке =операция умножения – срока Х на столбец а)

(именно в таком порядке =операция умножения – срока Х на столбец а)

Для решения задачи регрессии среди всех моделей ![]() нужно выбрать ту

нужно выбрать ту ![]() которая удовлетворяет условиям (*) наилучшим образом в смысле функционала (1)

которая удовлетворяет условиям (*) наилучшим образом в смысле функционала (1)

Матричную запись модели ![]() можно представить как

можно представить как ![]() уже выполн. условие

уже выполн. условие ![]() (вместо

(вместо ![]() ) с найденными оценками

) с найденными оценками ![]() .

.

То есть в результате решения мы находим такие ![]() которые формируют

которые формируют![]() наилучшим образом приближая условие

наилучшим образом приближая условие ![]()

Приближение это реализуется МНК как проектирующий механизм. Покажем это

Приближение это реализуется МНК как проектирующий механизм. Покажем это

Если выражение, которое нам надо приблизить в матричном виде выглядит как ![]()

то естественно что матричный аналог квадратичной невязки (1) –это

то естественно что матричный аналог квадратичной невязки (1) –это ![]() . Эта ошибка

. Эта ошибка ![]() есть расстояние от вектора

есть расстояние от вектора ![]() до вектора

до вектора![]() .

.

Вектор ![]() должен лежать в пространстве переменных (столбцов) матрицы

должен лежать в пространстве переменных (столбцов) матрицы ![]() , так как

, так как ![]() есть линейная комбинация столбцов этой матрицы с коэфф.

есть линейная комбинация столбцов этой матрицы с коэфф. ![]() .

.

Отыскание решения ![]() по методу наименьших квадратов эквивалентно задаче отыскания такой точки (вектора)

по методу наименьших квадратов эквивалентно задаче отыскания такой точки (вектора)

![]()

которая лежит ближе всего к ![]() и находится при этом в пространстве столбцов матрицы

и находится при этом в пространстве столбцов матрицы![]() .

.

Таким образом, вектор ![]() должен быть проекцией

должен быть проекцией ![]() на пространство столбцов

на пространство столбцов ![]() и вектор невязки

и вектор невязки ![]() должен быть ортогонален этому пространству.

должен быть ортогонален этому пространству.

Далее для упощения записи вывода формулы МНК отрбросим значки “тильда”

Ортоганальность вектора невязки ![]() пространству

пространству ![]() можно определить след образом:

можно определить след образом:

|

При произвольном ![]() вектор

вектор ![]() - это любой произвольный вектор, который можно положить в гиперплоскость построенную на векторах

- это любой произвольный вектор, который можно положить в гиперплоскость построенную на векторах![]() .

.

Для всех ![]() в пространстве

в пространстве ![]() , эти вектора должны быть перпендикулярны невязке

, эти вектора должны быть перпендикулярны невязке ![]() , в силу этого – условие отрогональности:

, в силу этого – условие отрогональности:

![]()

Так как это равенство должно быть справедливо для произвольного вектора ![]() , то

, то ![]() (*)

(*)

Таким образом мы нашли сооошение дающее решение по МНК несовместной системы условных уравнений ![]() , состоящей из n уравнений с m неизвестными (*)

, состоящей из n уравнений с m неизвестными (*)

![]()

которая называется системой нормальных уравнений

Если столбцы матрицы ![]() линейно независимы????, то матрица

линейно независимы????, то матрица ![]() обратима и можем получить решение для

обратима и можем получить решение для ![]() - одна их причин треб незав Х - и чем ближе к ЛЗ будут вектора тем хуже обусловлена

- одна их причин треб незав Х - и чем ближе к ЛЗ будут вектора тем хуже обусловлена ![]()

![]() (**)

(**)

Правда, естественно, решение не в том смысле, что оно превращает его в равенство, а в том, что в пространстве ![]() находит ближайший к нему вектор - проекцию

находит ближайший к нему вектор - проекцию ![]() . Вот для него имеем равенство

. Вот для него имеем равенство

![]()

Что и есть решение – основная народнохозяйственная ф-ла МНК

(брать производн. ф-ла,, приравн его=0, решать систему– проверте на примерах).То есть машина производных не берет а реалмзует полученную матричную формлу различными вычисдтельными процедурами. Самое слабое место – обращение матрицы, особенно при ее плохой обусловленности (корр переменных) – это будет у нас отдельный разговор.

*2 ====== Оператор проектирования. Свойства оператора.

Полученный результат имеет полезное для приложений свойство –

Из выражение ![]() получаем формулу оператора проектирования вектора

получаем формулу оператора проектирования вектора ![]() в плоскость

в плоскость ![]() :

:

Проекция вектора ![]() на пространство столбцов матрицы

на пространство столбцов матрицы ![]() имеет вид (подставляя значение

имеет вид (подставляя значение ![]() из (**))

из (**))

![]()

![]()

Матрица ![]()

называется матрицей проектирования вектора ![]() на пространство столбцов матрицы

на пространство столбцов матрицы ![]() .

.

Посмотрите какой интересный вид у нее.

Эта матрица имеет два основных свойства:

1. она идемпотентна ![]() , и

, и

2. онасимметрична - ![]() .

.

Проверим

1.![]()

![]()

2.по 2![]() =

=![]() =

=![]() =

=![]() =

=![]() Или более просто по 3- центральную скобку не трогаем при перестановке, края меняем местами и транспонируем, ценр тоже транспонируем

Или более просто по 3- центральную скобку не трогаем при перестановке, края меняем местами и транспонируем, ценр тоже транспонируем

![]() =

=![]() =

=![]()

Очень важно что верно и обратное: матрица Р, обладающая этими двумя свойствами есть матрица проектирования на свое пространство столбцов Х произвольного вектора У.

Данные свойства могут использоватся при проверке корректности использования МНК (в первую очередь зашумленность данных)

- потеря указанных свойств матрицей Р служит сигналом что оценки МНК (в силу нарушения условий применения - о них ниже ) потеряли свое качество

Структурно-параметрический синтез. Индуктивное моделирование

Переходя к третьоему столбцу (СИНТЕЗ ) Напомним что при моделировании мы решаем или о задачу параметр. синтеза ( при фикс. структуре) или задачу структурно-параметрического синтезу (СПС)

Коротко о проблемах СПС

Мы уже знаем что подход в лоб - с критерием "максимум точности" модели для задачи структурно параметрического синтеза в условиях

1 шумов в данных и

2. значимой корреляции между входными переменными

не корректен - почему ?

1- модель с нулевой ошибкой может оказатся абсолютно непригодной на свежих данных (переобученная модель) ..... пример ракета-волки

2.- вопрос а с какой же ошибкой считать модель оптимальной в алгоритмах ШМР например решается с помощью заданием оператором вероятностей

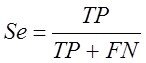

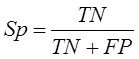

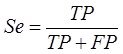

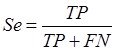

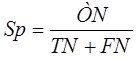

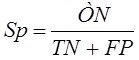

ошибок первого ![]() и второго рода -

и второго рода -![]()

Это вероятности ![]() при включении ложного арг в модель и -

при включении ложного арг в модель и - ![]() при исключении истинного аргумента из модели

при исключении истинного аргумента из модели

Но какие значения ![]() и

и ![]() нужны в каждом конкретном случае повисает в воздухе

нужны в каждом конкретном случае повисает в воздухе

3.- модель с сильно коррелированными (близкими к коллинеарности) аргументами может оказатся крайне неустойчивой к смене (даже однородных) обучающих выборок, при этом замена даже 1 точки или 1признака может дать существенную дисперсию оценки параметров модели.

4.- Кроме того проблемы плохой обусловленности ХтХ часто не позволяют в принципе получать решение задачи в лоб как у= (ХтХ)-1ХтУ

Поэтому был предложен ряд методов который в оговоренных выше тех или иных условиях позволяет получать наилучшие в некотором смысле модели.

Эти методы объединены названием (так введено основателями теор самоорганизации)

"Индуктивное моделирование" а вот подтверждение насколько тот или иной метод лучше более или менее может быть подтвержден (до испытаний на новых объектных данных) только модельным экспериментом который восстанавливает насколько это возможно

условия формирования экспериментальных данных и проверяет

насколько точно проверяемый подход открывает преполагаемую структуру и параметры модели.

Кратко по сути модельного эксперимента чуть позже далее

К1------ -------

Cтруктурно-параметрический синтез регрессионных моделей

Индуктивное моделирование - Как выбирать структуру модел

Напомним коротко что уже знаем

Постановка задачи структурного синтеза

Заданы, как обычно, матрица наблюдений Х(n*m), вектор отклика Y(n*1)

предполагается задание

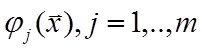

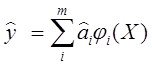

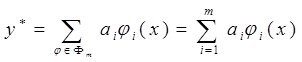

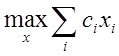

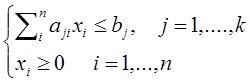

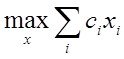

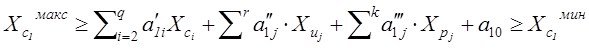

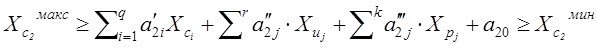

А) перечня аргументов Х1….ХM, с избытком для синтеза модели: , M>m (лин. случай). Необходимо найти наилучшую модель  или

или

Б) предполагается синтез наилучшей нелинейной модели тогда количество обобщенных аргументов φj(x), j=1,...,m,...неисчерпаемо.

тогда количество обобщенных аргументов φj(x), j=1,...,m,...неисчерпаемо.

Очевидный вариант, - давайте усложнять структуру модели до тех пор, пока не получим «нулевую ошибку» (то есть догоняем структуру до m= n) - не проходит, так как любая структура удовлетворит такой «0-й ошибке», в том числе связывающая скорость ракеты с поговьем волков в Тамбовской области. В идеальных условиях:

отсутствие шумов в данных и независимость (или менее корректное и более слабое условие - отсутствие корреляции) случайных входных аргументов, возможно применить (не всегда –только при достаточно больших n, чтобы рассматривались модели при m<n) подход в лоб

Моделирование по полному списку аргументов (знаем)

Заметим что в оговоренных идеальные условия применения любых известных структурно-параметрическихметодов синтеза (СПС) - отсутствие шумов в данных и независимость случайных входных признаков - тогда и классические ШАМР и методы ИМ будут давать близкие приемлемые результаты

Однако обозначенные идеальные условия – иллюзия

- …шум вычислений всегда присутствует,

- практически всегда присутсттвует коррелированность аргументов, даже порожденных ГСЧ (корреляция 0.3-0.07) ,

- не говоря о постановке Б), где коррелированность заложена в постановке задачи (корреляция –то есть аппроксимация лин. зависимости есть и в нелинейных базисах …. )

Проблемы нарушения условий применения МНК приводятв СПС к различным отклонениям в

1.оценках параметров (состоятельности, несмещенности, эффективности)

2. включению фиктивных аргументовв модель вместо истинных

Как мы уже знаем наращивать точность до 0-й ошибки - плохая стратегия. Модели должны быть более простые, чем достигающие 0-й ошибки при m= n. В этой ситуации любая структура даст 0-й ошибку.

А какой механизм выбрать для получения более простых (с ненулевой ошибкой) структур, которые наболее соответствовали нашим ожиданиям?

– минимальной ошибке на новых точках?

(имеено эта сверхзадача обычно стоит за любой задачей моделирования).

Решение проблемы проводится по 2-м направлениям

1. Отбор наилучших структур осуществляется за счет применения механизма штрафов за сложность модели в явном виде

Механизмы учитывают доступную информацию о шумах в выходных данных и позволяют получать оптимально упрощенные (по отношению к даже истинной структуре) - модели. Оптимальные, например с точки зрения точности прогноза на тестовых данных

2. Отбор наилучших структур осуществляется за счет применения штрафа за сложность в неявном виде.

Данный механизм чаще применяется в наиболее сложных условиях когда о шуме не предполагается известных оценок и этот подход также обеспечивает решение сверхзадачи – минимизацию ошибки модели на новых выборках.

- 1.Первый путь (явный штраф засложность) частично реализуется в классических ШАМР и принципе отбора моделей по критериям Акаике, Шварца и Меллоуза

- 2. Второй путь (неявный штраф за сложность) основан на различных принципах нахождения новых, свежих выборок и отбор осуществляется тех структур моделей, которые обеспечивают минимум ошибки моделей на этих свежих данных.

Методы, которые предлагают свой ответ на вопрос как сформировать новые выборки данных - это

А) будстреп, Б) метод складного ножа (джек найф), и В) МГУА

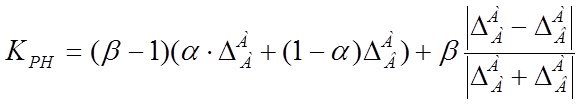

В МГУА предложены варианты внешнего критерия которые обеспечивают модели оптимальной сложности для различных содержательных задач (аппроксимация, прогноз, дискриминация) и различных условий синтеза моделей.

Методы моделирования с явным штрафом за сложность моделей

Классические шаговые алгоритмы многомерной регрессии

Мы уже знаем ШАМР - напомним их. Новое тут - в анализе проблем ШАМР

Наиболее распространенные ШАМР – три следующих алгоритма –

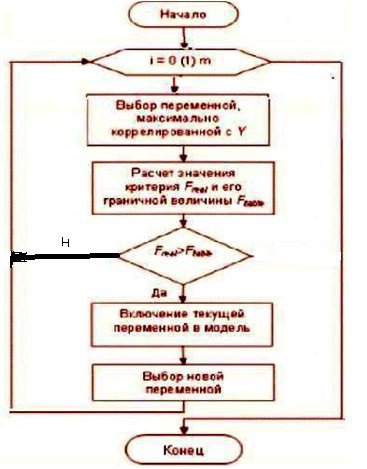

1. Метод прямого отбора МПрО (Forward Selection) или

метод последовательного включения

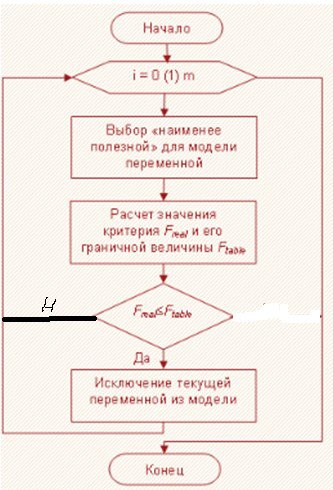

2. Метод обратного исключения МОИ (Backward Elimination) или

метод последовательного исключения

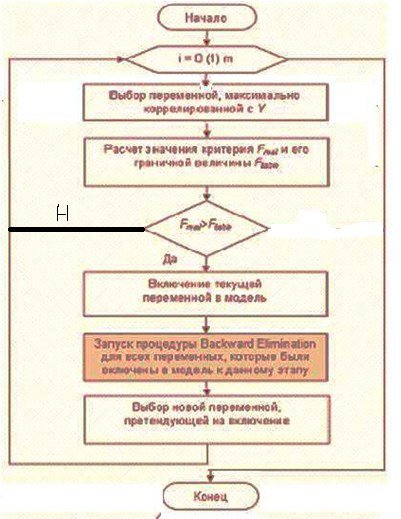

3. Метод последовательного отбора МПО (Stepwise) или

метод последовательного включения и исключения

метод последовательного включения и исключения

Данные шаговые регрессионные алгоритмы идеологически похожи. Постулируется некоторый начальный состав аргуметов в начальной модели - при МПрО и МПО – состав пуст – константа, начальный состав при МОИ - полное описание – состав из всех претендентов аргументов.

В методе последовательного отбора МПО на основании некоторого порогового критерия принимается решение о вводе или не вводе в модель  претендента

претендента ![]()

ВМетоде обратного исключения “Backward Elimination” на основе подобного же критерия критерия принимается решение о выводе или не выводе из модели претендента на аргумент модели.

Метод последовательного отбора МПО решение о вводе в модель некоторого аргумента – затем просматриваются все остальные ранее вошедшие в модель аргументы – и на основе того же порогового критерия определяется - не следует ли теперь вывести из модели какой-либо аргумент из вошедших ранее

Замечание: во избежание зацикливания процесса включения исключения значимость включения устанавливается меньше значимости исключения

В ШАМР для отбора лучших структур используют

- порог критерия качества модели (связанный с уровнем значимости) и

- коррекцию формулы расчета критерия качества модели, учитывающий штраф за сложность модели.

Подход имеет недостаток в том смысле что не формализует очевидным образом выбор порога в зависимости от условий моделирования (дисперсия и параметры шума, степень коррелированности входов и тд)

А используемый механизм штрафи за сложность – (деление на n-m) мало чувствителен к условиям моделирования при больших и средних значениях n –кол. точек

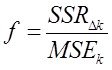

Остается привести формулу расчета статистики Фишера (F теста) который был создан для сравнения и выводов о различие дисперсий.

Введем обозначения

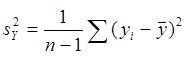

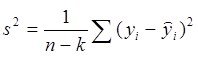

|

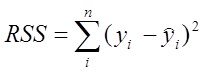

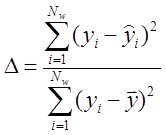

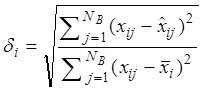

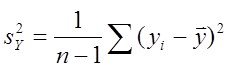

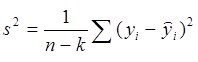

· ![]() — сумма квадратов ошибок, - здесь

— сумма квадратов ошибок, - здесь

![]() - наблюдаемые значения,

- наблюдаемые значения, ![]() - значения модели

- значения модели

·

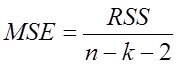

· ![]() — среднеквадратичная ошибка, - в завис. от шага использования -

— среднеквадратичная ошибка, - в завис. от шага использования -

ее в методе шаговой регрессии

где ![]() - количество точек,

- количество точек, ![]() - количество оцениваемых параметров модели

- количество оцениваемых параметров модели ![]() - число степеней свободы модели, (-2). – потому что учитывается свободный член модели и одна степень свободы у среднего

- число степеней свободы модели, (-2). – потому что учитывается свободный член модели и одна степень свободы у среднего ![]() .

.

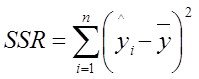

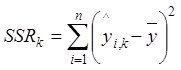

- сумма квадратов регрессии

- сумма квадратов регрессии

Есть ![]() до ввода регрессора претендента в модель -

до ввода регрессора претендента в модель - ![]() ,

,

есть ![]() после ввода регрессора претендента в модель

после ввода регрессора претендента в модель ![]()

и есть разница ![]()

Сумма квадратов регрессий при введении полезного аргумента  увеличивается и стремится к значению

увеличивается и стремится к значению

Поэтому аргумент с большим приростом ![]() - лучше.

- лучше.

Соответственно рассматриваются ![]() и

и ![]() - значение среднеквадратичной ошибки до и после ввода регрессора в модель

- значение среднеквадратичной ошибки до и после ввода регрессора в модель

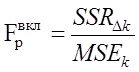

Тогда статистку  (*) называют критерием или F-тестом Фишера. применительно к шаговой регрессии. Доказано что данная статистика распределена по закону Фишера и ее используют для определения порога отсева аргументов по значению улучшения дисперсии модели.

(*) называют критерием или F-тестом Фишера. применительно к шаговой регрессии. Доказано что данная статистика распределена по закону Фишера и ее используют для определения порога отсева аргументов по значению улучшения дисперсии модели.

Вопрос:

Зачем для определения порога отсева аргументов рассматривать отношение  (*) а не просто улучшение ошибки

(*) а не просто улучшение ошибки![]() или прирост

или прирост ![]() ????. – Резон в том что это отношение расределено по известному закону Фишера и для определения состава аргументов модели привлекают механизм проверки статистических гипотез:

????. – Резон в том что это отношение расределено по известному закону Фишера и для определения состава аргументов модели привлекают механизм проверки статистических гипотез:

При реализации процедурывключения аргумента - рассматривается гипотеза H0 , что улучшение качества модели незначимо.

То есть Н0 состоит в том что введенный аргумент - ложный.

Проверка гипотезы H0 сводиться к последовательности действий:

1. Задаемся уровнем значимости ![]() , например 0,01 или 0,05.

, например 0,01 или 0,05.![]() характеризует риск принятия неправильного решения. То есть риск введения ложного аргумента (вероятность ошибки 1 рода)

характеризует риск принятия неправильного решения. То есть риск введения ложного аргумента (вероятность ошибки 1 рода)

2. По специальным таблицам находим -процентную точку ![]() распределения Фишера со степенями свободы d1=1 d = n-k-2 (для формулы (**) степень свободы определяется как d1=(п-k)-(n-k-1)=1). Это значение будет являться нашим пороговым для статистики (*).

распределения Фишера со степенями свободы d1=1 d = n-k-2 (для формулы (**) степень свободы определяется как d1=(п-k)-(n-k-1)=1). Это значение будет являться нашим пороговым для статистики (*).

Сравниваем точку![]() со значением расчетной статистики

со значением расчетной статистики ![]() .

.

Если окажется, что![]() , то делается вывод о значимости введенного признака и, соответственно, его следует включить в модель (отдается предпочтение гипотезе H1 с вероятностью

, то делается вывод о значимости введенного признака и, соответственно, его следует включить в модель (отдается предпочтение гипотезе H1 с вероятностью ![]() ошибиться).

ошибиться).

Если же![]() , то принимается решение о неэффективности включения переменной в модель,то есть гипотеза H0 принимается с вероятностью

, то принимается решение о неэффективности включения переменной в модель,то есть гипотеза H0 принимается с вероятностью![]() как не противоречащая экспериментальным данным.

как не противоречащая экспериментальным данным.

( здесь p(F) = -плотность распределения Фишеровской случ величины, чем выше (боль) порог

( здесь p(F) = -плотность распределения Фишеровской случ величины, чем выше (боль) порог ![]() тем меньше уровень значимости

тем меньше уровень значимости ![]() - ошибк.1 род).

- ошибк.1 род).

На рис. видим что зона допуст. расчетных значений ![]() лежат выше (в смысле справа) порога

лежат выше (в смысле справа) порога ![]() , а соответствующая зона расчетной ошибки 1рода -

, а соответствующая зона расчетной ошибки 1рода - ![]() (площадь под хвостом)-должна быть меньше порогового уровня уровня значения ошибки 1-ого рода -

(площадь под хвостом)-должна быть меньше порогового уровня уровня значения ошибки 1-ого рода - ![]() . Таким образом задавая в Stepwise

. Таким образом задавая в Stepwise ![]() =допустим 0.05 (или соответств

=допустим 0.05 (или соответств ![]() ) -что есть вероятность вкл. ложного аргумента (вер ош 1 рода) мы этим параметром полностью доопределяем процедуру включения аргументов в модель.

) -что есть вероятность вкл. ложного аргумента (вер ош 1 рода) мы этим параметром полностью доопределяем процедуру включения аргументов в модель.

Аналогично при процедуре исключения аргументов из модели рассматривается гипотеза H0 , что ухудшение качества моделинезначимо

Соответственно выбранный уровень значимости ![]() =допустим 0.1 (или соотв

=допустим 0.1 (или соотв ![]() ) - есть вероятность исключения истинного аргумента (вер ошибки 2-го рода). Соответственно решение о принятии H0 "гипотезы о незначимости аргумента" - и исключении аргумента из модели реализуется при выполнении условия

) - есть вероятность исключения истинного аргумента (вер ошибки 2-го рода). Соответственно решение о принятии H0 "гипотезы о незначимости аргумента" - и исключении аргумента из модели реализуется при выполнении условия ![]() . То есть область допустимых для исключения значений

. То есть область допустимых для исключения значений![]() лежит слева от

лежит слева от ![]()

1-к

---------- ====

2 Л

Проблемы методов структурной идентификации

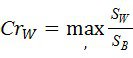

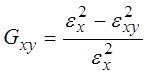

Обратим внимание на множитель (![]() ) в формуле МST и попадающий в числитель в статистике Фишера (*)

) в формуле МST и попадающий в числитель в статистике Фишера (*)

Чем сложнее модель тем более корректируется расчетное значение критерия в сторону уменьшения (то есть ухудшения) препятствуя включению аргумента в модель. Таким образом мы видим что даже классичский ШАМР уже использовал определенную форму штрафа за сложность модели. Правда его влияние при больших n незначительно и практически не влияет на структуру модели.

Другие проблемы ШАМР

1. Для конкретных условий шума в данных (в Х и У) соотношение ![]() и

и ![]() - свое "с точки зрения наиболее точного прогноза на свежих точках или более общо - с точки зрения "внешнего критерия" который мы определяем как "истина для нас " - в то время как сам алгоритм ШР опирается лишь на точность текущей обуч выборки и значение

- свое "с точки зрения наиболее точного прогноза на свежих точках или более общо - с точки зрения "внешнего критерия" который мы определяем как "истина для нас " - в то время как сам алгоритм ШР опирается лишь на точность текущей обуч выборки и значение ![]() и

и ![]() предлагает выбирать нам.

предлагает выбирать нам.

2. известный недостаток теории стат. гипотез:

только результат по введению аргумента (не принятию H0 ) в ней считается достоверным. Результаты по принятию H0 в обще-то ничего не гарантирует. Применяется такая хитрозделанная формулировка – принятие гипотезы H0 не противоречит исходным данным.

= это приблизительно так как если бы у вас во дворе се8одня ночью убили дворника и обвинили в этом меня только на том основаниии что я спал дома один и некому подтвердить мое алиби. Так ведь еще в эту ночь 200 тыс киевлян спали одни – однако от этого вывод не меняется – гипотеза об обвинении в убичтве принимается на том основании что она не притиворечит исходны. данным. – Так накопайте другие данные – или лучше смените алгоритм - но как часто бвыает в жизни – лень и пользуются тем что имеют.

3. Кроме того, уменьшая ![]() (увелич порог качества аргумента) мы не тоько увеличиваем вероятность правильного отвержения ложного аргумента 1-

(увелич порог качества аргумента) мы не тоько увеличиваем вероятность правильного отвержения ложного аргумента 1- ![]() но и очевидно увеличиваем вероятность отвержения вместе с ним и истинного аргумента увеличиваем ошибку второго рода -истинный аргумент тоже может не проскочить слишком высокий порог ФИШЕРА.

но и очевидно увеличиваем вероятность отвержения вместе с ним и истинного аргумента увеличиваем ошибку второго рода -истинный аргумент тоже может не проскочить слишком высокий порог ФИШЕРА.

И магическое число ![]() =0,05 совсем не магическое и в разных задачах при разных шумах и разных корреляциях истинных и ложных аргументов с выходом (в некоторых случаях корреляция ложного будет выше корреляции истинного с выходом - зависит от коэффициента при соответствующем аргументе в модели) это число имеет свое опт значение - а какое ???? - проблема проблема

=0,05 совсем не магическое и в разных задачах при разных шумах и разных корреляциях истинных и ложных аргументов с выходом (в некоторых случаях корреляция ложного будет выше корреляции истинного с выходом - зависит от коэффициента при соответствующем аргументе в модели) это число имеет свое опт значение - а какое ???? - проблема проблема

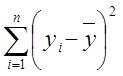

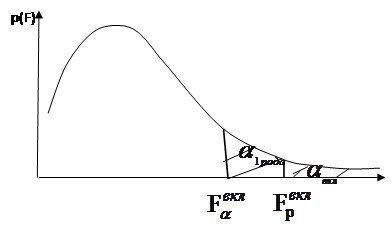

4. Адекватность (статистическая значимость ) получен. уравнения регрессии

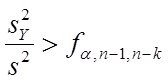

Для проверки значимости уравнения регрессии “в целом” используется критерий Фишера: если

то уравнение регрессии адекватно (статистически значимо) описывает результаты эксперимента при (

то уравнение регрессии адекватно (статистически значимо) описывает результаты эксперимента при (![]() ) - процентном уровне значимости. Отношение (полной

) - процентном уровне значимости. Отношение (полной и остаточной

и остаточной  дисперсий)

дисперсий) ![]() показывает, во сколько раз уравнение регрессии аппроксимирует предсказывает результаты опыта лучше, чем среднее

показывает, во сколько раз уравнение регрессии аппроксимирует предсказывает результаты опыта лучше, чем среднее ![]() , где k – сумма числа входных переменных плюс свободный член.

, где k – сумма числа входных переменных плюс свободный член.

Необходимо помнить, что доверительная оценка отклонения эмпирической линии регрессии от теоретической резко ухудшается по мере удаления от среднего значения ![]() . В частности, по этой причине опасна экстраполяция эмпирической регрессионной зависимости за пределы интервала входных переменных

. В частности, по этой причине опасна экстраполяция эмпирической регрессионной зависимости за пределы интервала входных переменных ![]() , для которого она получена

, для которого она получена

По сути это значит что заранее признается неработоспособность модели на новых свежих данных если они по сути не повторяют старые!!!!!

И этот аргумент у нас будет одним из главных в критике, потому что если в алгоритме нет серьезных механизмов настройки структуры модели то она будет беспомощна в реальных условиях применения на живых данных

Ниже мы рассмотрим механизмы штрафов (критерии) которые более чувствительно и обоснованно реагируют на усложнение модели

Критерии с явным штрафом за сложность модели (продолжение)

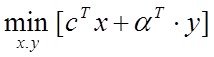

И так постулируем следующие части алгоритма структурно-параметрического синтеза.

1.Генератор структур -(он может быть более или менее удачным, то есть более или менее удачно решить выбор пути неполного перебора структур (если перебор полный то это самый простой алгоритм генерации)

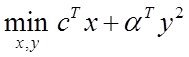

2.Механизм расчета параметров (МНК, ЗЛП, град. Процедуры)

3. Критерии выбора структуры (внешние критерии)

Будем сейчас вести речь о самом интересном –критериях отбора структур.

1 Пусть известна ![]() дисперсия шума

дисперсия шума

Наиболее подходящий критерий для выбора структуры оптимальной сложности при условии известности ![]() дисперсии шума есть

дисперсии шума есть

Критерий Маллоуза

Критерий Маллоуза оказываеся дает при этом несмещенную оценку ошибки прогнозирования

, ![]() где RSS – квадрат нормы невязки у,

где RSS – квадрат нормы невязки у, ![]() - дисперсия шума,

- дисперсия шума, ![]() - сложность модели (для лин модели -количество расч параметров).

- сложность модели (для лин модели -количество расч параметров).

Но надо знать дисп шума ![]() , тогда этот критерий позволяет отобрать структуру с наилучшей оценкой прогноза,

, тогда этот критерий позволяет отобрать структуру с наилучшей оценкой прогноза,

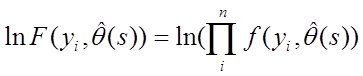

2.Пусть известно распределение шума ![]()

Когда известно распределение шума ![]() можно построить функцию распределения модели у с учетом этого распределения шума

можно построить функцию распределения модели у с учетом этого распределения шума ![]() ,

,

Для нахождения параметров ![]() предполагаетсяч использование метода наибольшего правдоподобия. Как известно, для этого надо найти такие

предполагаетсяч использование метода наибольшего правдоподобия. Как известно, для этого надо найти такие ![]() которые доставляют максимум ф-ции правдоподобия

которые доставляют максимум ф-ции правдоподобия  при каждом варианте структуры

при каждом варианте структуры ![]() в известных точках

в известных точках ![]() .

.

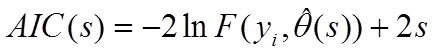

Тогда для поиска оптимальной структуры ![]() используется информационный критерий Акаике (AIC):

используется информационный критерий Акаике (AIC):

где ![]() - максимизированное значение функции правдоподобия модели.

- максимизированное значение функции правдоподобия модели.

В частном случае нормального шума он принимает вид критерия Маллоуза. При этом на практике он применяется в упрощенном виде

![]()

Этот вариант формулы называют критерием Акаике-Маллоуза

Данный критерий существенно ограничивает рост сложности модели наличием аддитивного члена 2s. Однако проблема применения состоит в том, что в практических задачах функция распределения шума да часто и его дисперсия неизвестны.

А что тогда делать? Используют тогда менее обоснованные но практически неплохо работающие критерии

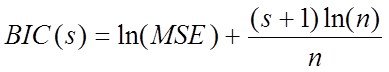

3. Байесовский информационный критерий (критерий Шварца):

4. Также популярен критерий финальной ошибки предсказания Акаике применяемый при неизвестном характере шума и корректирующий остаточную сумму квадратов ошибки

Критерии с использованием штрафа за сложность в неявном виде и с порождением новых выборок

1. Бутстреп – предполагается что раз данные n точек появились у нас в віборке то у них равная вероятность появления в віборке - отсюда алгоритм получения подобных выборок - имитационное моделирование исходной выборки с помощью равномерного распределения - ключевой момент если некоторая точка реализовалась она возвращается в множество генерации (т.о. получаем выборки размером n с возможным количеством повторения некоторых точек)

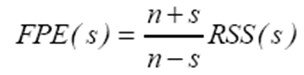

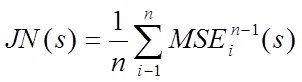

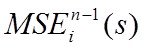

2. Критерий "скользящего контроля", "усредненный критерий регулярности", или "джекнайф"-складной нож:

Используется при крайне малом количестве точек ( когда точек просто маловато используют разбиения выборки по МГУА -- ниже)

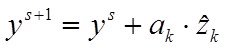

- значение критерия MSEi при синтезе модели на n-1 точке - то есть при выброшеной из выборки i-той точке при данном s. Когда s определено - считаем параметры на полной выборке.

- значение критерия MSEi при синтезе модели на n-1 точке - то есть при выброшеной из выборки i-той точке при данном s. Когда s определено - считаем параметры на полной выборке.

КРИТЕРИИ С РАЗБИЕНИЕМ ВЫБОРКИ

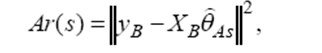

Внешние критерии, применяемые в М ГУА.

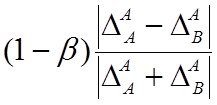

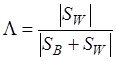

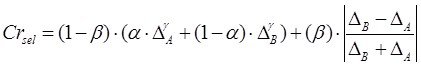

Здесь принцип компромисса (в неявном виде) достигается за счет разбиения выборки на две части. По одной части – „внутренней” –

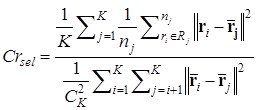

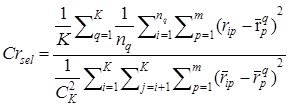

осуществляется оценивание параметров, по другой – „внешней” – определяется прогнозирующая способность моделей. К этой группе относится критерий регулярности:

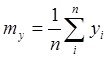

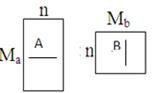

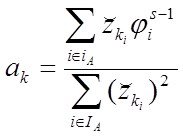

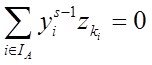

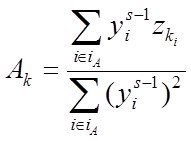

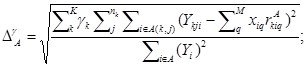

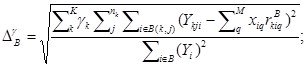

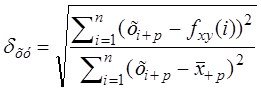

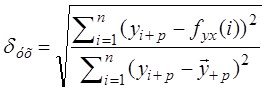

где A и B – соответственно обучающая и проверочная части выборки,

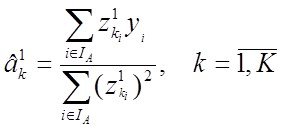

где A и B – соответственно обучающая и проверочная части выборки, ![]() – оценка параметров модели сложности s по МНК на подвыборке А.

– оценка параметров модели сложности s по МНК на подвыборке А.

Комментарий к материалу

Поскольку во всех методах есть какие-то проблемы - (хотя с моей точки зрения алгоритмы МГУА наиболее совершенны и технологичны в настоящее время), то если бы рядом со мной стоял «старый зубр» - статистик (например Цейтлин Натан Абрамович автор книги “из опыта аналитического статистика”) он сумел бы доказывать что и Акаике и МГУА не совершенны, а в рамках АШР он, Цейтлин сможет получать модели не хуже чем мы по МГУА

Ну что же. В этом он наверное прав. Но для этого надо быть Цейтлиным, и иметь многолетний опыт практической работы статистика, чтобы преодолевать проблему множественности моделей с помощью своего многолетнего опыта.

Для других практиков, не такого высокопрофессионального уровня, то методология МГУА и рекомедации, которые мы рассмотрели выше позволят вам решать сложные практические задачи моделирования не хуже Цейтлина.

Подведем промежуточные итоги:

Если вам известны распределение шума или его дисперсия применяейте информационный критерий Акаике или Маллоуза соответственно.

Если параметры шума неизвестны и выборка критически мала, наиболее подходящий подход – «джекнайф». В других случаях я бы рекомендовал различные алгоритмы МГУА.

Таким образом несмотря на достаточно подробное разложение проблем структурного моделирования - что в каких случаях рекомендуется применить значительное количество методов при неизвестных параметрах шума и коррелированности входных переменных могут выступать конкурентами при решении задач моделироания

– это критерий Шварца, различные алгоритмы МГУА, в некоторых случаях ШАМР, другие, не рассмотренные нами неклассические подходы к моделированию:

-агентное моделирование, генетические алгротритмы, нейронные сети и прочее..

Для того что бы вы, (которые не “неЦейтлины”), сами могли решить вашу задачу, смогли решить: вот данный, конкретный метод, подходит ли вам для решения вашей конкретной задачи, Вам необходимо сформировать собственное мнение о применяемых и сравниваемых алгоритмах.

Для этого вам надо хорошо в первую очередь разобраться в своей прикладной задаче. То есть хорошо представлять особенности данных и иметь хотя бы общие предположения о классе опорных функций (степенные, гармонич …..) и порядке сложности предполагаемой модели.

Тогда существует эффективный подход для определения адекватности метода вашей конкретной задаче – конструирование модельного примера.

Проверка структуры модельным экспериментом

Если вы разбираетесь в сути вашей практ. задачи то проверить метод на адекватность в конкретных условиях достаточно просто – создать модельный пример: то есть

задаемся предполагаемой моделью,

задаемся аргументами с запасом (истинные и фиктивные),

генерируем входные данные,

по заданной модели считаем выход.

Полученные входы и выход даем на вход тестируемого алгоритма и смотрим что он нам нарисует. Рассмотрим что такое при этом хорошо и что такое плохо. Если

1. метод при отсутствии шума в данных и некоррелированности входных аргументов дает решение на нашей структуре – это нормально. В противном случае метод безоговорочно не подходит как не обладающий сходимостью к истинной структуре.

2. Медот сходится к истинной структуре в большинстве практически значимых случаях пр условии коррелированности входных аргументов. Это хорошо - значит он обладает сходимостью к истинной структуре отфильровывая фиктивные аргументы и отбирая истинные в модель.

3. если при коррелированности аргументов и введении шума метод

3а)упрощая модель (в условии шума более простые модели обладают меньшими ошибками чем более сложные и при этом даже истинные)

обеспечивает минимальную ошибку на свежих данных – это говорит о том что синтезируутся модели оптимальной сложности – и это хорошо – для таких моделей будем иметь минимальные ошибки и прогноза и аппроксимации на новых данных

3б) Если метод при этом остается на подмножестве истинных аргументов – это отлично, так как решает сразу 2 задачи – получает модель оптимальной сложности при этом на подмножестве истинных аргументов.

К какому варианту стремится – к 3а или 3б зависит от цели задачи.

–Если стоит задача прогноза или аппроксимации в сравнительно неизменных условях – то очевидна полезность 3а.

- Если стоит та же задача в сильно изменяющихся условиях или задача поразумевает влияние на изучаемый процесс через истинные аргументы (то есть нужна модель максимально приближенная к физической модели) то необходимо решение как в 3б.

-------------

Независимая вставка ---------------

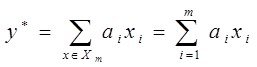

Таким образом при фиксации условий моделировании (как в модельных примерах так и в реальной задаче) необходимо различать три ситуации:

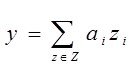

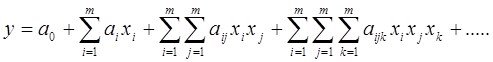

1. Конструируемые модели линейны  , - строятся на множестве

, - строятся на множестве ![]() , здесь

, здесь ![]() - истинные аргументы, остальные

- истинные аргументы, остальные ![]() - фиктивные

- фиктивные

Входное множество Х – независимые переменные, (шума в данных нет)

Задача: отыскать среди всех моделей  которые можно построить на Х - истинную модель

которые можно построить на Х - истинную модель

(почему мы вводим фиктивные переменные?? – потому что в реальной задаче мы никогда не знаем истинной структуры, что входит в модель – то есть мы копируем реальную практическую ситуацию)

2. Конструируемые модели нелинейны,(шума в данных нет),

строятся на базисе ![]() ,

,

здесь ![]() - множество истинных аргументов нелинейной модели, остальные -

- множество истинных аргументов нелинейной модели, остальные -![]() - фиктивные,

- фиктивные, ![]() - вектор входных аргументов

- вектор входных аргументов ![]() . Среди моделей

. Среди моделей  ищем истин. модель

ищем истин. модель

Как видим вторая задача может быть сформулирована точно как первая с точность до переобозначения ![]() (кроме…):

(кроме…):

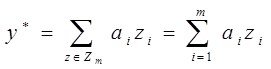

2.а Конструируемые модели линейны, строятся на базисе

![]() , здесь

, здесь ![]() - множество истинных аргументов, остальные -

- множество истинных аргументов, остальные -![]() - фиктивные, Среди моделей

- фиктивные, Среди моделей  ищется истинная модель

ищется истинная модель

(***) Но неременные zi, ![]() могут быть коррелированы – это единсвенное но важнейшее отличие в данных постановках.

могут быть коррелированы – это единсвенное но важнейшее отличие в данных постановках.

Т.о. п.2 может быть сформулирован точно как п.1

только с условием  то. Есть

то. Есть

2б.Конструируемые модели линейны  но имеется условие (***) возможной коррелируемости входных переменных.

но имеется условие (***) возможной коррелируемости входных переменных.

И наконец.

3. В данных ….. присутствует шум в общем случае неизвестого уровня распределения и точек приложения.

Рассмотрим первую ситуацию.

Очевидно, что в данном случае любой шаговый алгоритм справится с открытием истинной струкуры, ведь любой аргумент ![]() для которого

для которого ![]() будет истинным (за сключением множества фиктивных аргументом мощности меры 0, вероятность наличия которых в нашем списка = 0 – то есть вмешаться может только слепой случай)

будет истинным (за сключением множества фиктивных аргументом мощности меры 0, вероятность наличия которых в нашем списка = 0 – то есть вмешаться может только слепой случай)

Покажем это

Итак, по формулировке 1. – имеем

![]() для всех

для всех ![]() в силу их независимости и

в силу их независимости и

![]() для всех

для всех ![]() истинных (по определению, истинный аргумент имеет связь с выходом)

истинных (по определению, истинный аргумент имеет связь с выходом)

Предположим обратное,

что для некоторого ![]() выполняется

выполняется ![]()

Тогда ![]() связан с выходом

связан с выходом ![]() .

.

И при этом по определению не является истинным аргументом.

Когда такое возможно? – либо это случайность (генератор так случайно сгенерировал ![]() - этомножество меры 0, вероятность которого - 0) либо

- этомножество меры 0, вероятность которого - 0) либо ![]() связан с неким

связан с неким ![]() , то есть

, то есть

для них ![]() , что противоречит условию независимости всех

, что противоречит условию независимости всех ![]()

Поскольку выбор в претенденты на участие в модели происходит в шаговых алгоритмах по величине ![]() то оно последовательно включит истинные аргументы в модель.

то оно последовательно включит истинные аргументы в модель.

----------------------

Вот во всех остальных случаях, у классических шаговых алгоритмах начинаются сложности. Если

1.поданные на вход переменные (истинные и фиктивние) независимы а

2. данные точные без шума и

3.при этом количество наблюдений ![]() количества претендентов на аргументы в модель

количества претендентов на аргументы в модель

то с такой задачей открытия истинной модели могут справится классические шаговые и другие неклассические методы индуктивного моделирования. Покажем это.

Более серьезные проблемы ШАМР

Первым проблемным изменением в постановке – отмена независимости входных аргументов. Это реальная проблема в силу того что

1.в реальности входные аргументы часто могут быть коррелированы (СОЕ и температура, белок в моче и краетинин в крови и тд )

2. истинный характер модели нам не известен и в качестве претендентов на входящие аргументы мы должны формировать различные нелинейные комбинации из исходного набора входных аргументов. Ну тот самый базис ![]() о котором мы упоминали выше

о котором мы упоминали выше

Для сведения:

линейная корреляция х и х2 где-то 0.97 а х и х3 - 0.95 и теперь при истинных аргументах х1 и х2 , аргумент х1х2 может быть фиктивным, но тем не менее иметь большую корреляцию с выходом.

В таких условиях классические шаговые алгоритмы сталкиваются с поблемой множественности решений.

Истинные и фиктивные коррелируют, конкурируют и претендуют на вход в модель. При этом сильно коррелирующий фиктивный оттесняет слабо влияющего с малым коэффициентом истинный аргумент. В результате путь к истинной модели ША может циклится или вообще к ней не прийти. Можете сами попробовать – в этих условиях раззичные алгоритмы дадут результирующие различные структуры, Один и тот же алгоритм часто даст вам разные решения при смене условий счета

– изменений в данных,

- изменений в составе переменных (при неизменной истинной модели и неизменном присутствии истинных аргументов)

- изменений в порядке ввода- вывода аргуменнтов в модель

- изменений в значениях порогов отсева аргументов.

Точное решение возможно только при полном переборе всех моделей претентентов – только тогда получим истинную модель

Но полные перебор чаще всего не возможен –

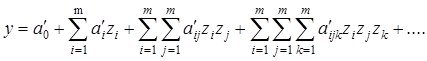

Действительно рассматривая скажем степенные модели -

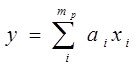

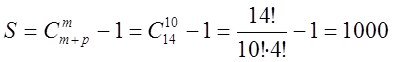

Количество членов полного полинома Колмогорова – Габора –

При ![]() при входных аргументах и заданной

при входных аргументах и заданной ![]() -той его степени

-той его степени

количество членов такого полинома можно рассчитать по формуле

![]() а количество частных моделей которые можно образовать из этого полинома -

а количество частных моделей которые можно образовать из этого полинома - ![]()

Пример.

Таким образом при несчастных 10-ти входных аргументах 4 степени полного описания порождает полинома с  что порождает

что порождает ![]() моделей претендентов - это приблизительно

моделей претендентов - это приблизительно ![]() моделей которые можно из него построить.

моделей которые можно из него построить.

Это число не только изобразить его вообразить невозможно. Тем более пересчитать эти модели.

Попробуте их перебрать за реальное время …..

Итак вывод:

- корреляция входных переменных порождает необходимость разрешения проблемы множественности моделей и соответственно

огромного количества возможных путей перебора среди которых ничтожное меньшинство приводит к модели истинной структуры.

Необходимо предложить решения, позволяющие найти пути к истинной или квазиистинной модели, не прибегая к процедуре полного перебора –

Рассмотренные выше шаговые классические алгоритмы на практике такие задачи решают не эффективно.

Хотя решить такую задачу казалось бы очень просто – задать полный полином и найти по МНК для него коэффициенты для полной структуры.

В этом случае для фиктивных аргументов в уравнении как бы должны выйти нули. Почему же не пользуются этой возможностью?

Потому что, как мы помним, из корреллированности входных аргументов следует воможность коррелированности выходной переменной и фиктивных – что создает реальную конкуренцию при выборе структуры между истинными и фиктивными аргументами.

Еще более усложняет выбор структуры наличие шума в данных.

Ситуация 3

3.Проблема шума в данных

Итак, все дело в шуме, который обязательно присутствует в любых данных и даже минимальные уровень которого, деформирует исходные корреляционные отношения так, что из полного полинома невозможно увидеть истинную структуру.

Теперь оценки параметров при фиктивных, но коррелированных с выходом аргументах, уже точно не будут нулевыми, а значимыми или незначимыми они будут и, насколько значимыми, оценить заранее невозможно.

И даже при полном отсутствии шума в данных, шум все равно в расчетах присутствует, и, чем выше корреляция аргументов, тем хуже обусловленность матрицы (детерминант системы ближе к нулю) аргументов и тем выше уровень вычислительного шума. Поэтому никто мало кто (напрямую) при коррелированных аргументах не оценивает параметры полного полинома.

Более подробно.

И так, коррелированность обуславливает

1. близость к нулю главного дискриминанта матрицы аргументов – чем выше коррелированность аргументов, тем ближе дискриминант к нулю, тем выше погрешность вычислений.

Однако, проблема коррелированности аргументов в присутствии шума имеет еще одну важную особенность:

2. роль самого шума в искажении оценок параметров многократно возрастает. Оценки становятся и несостоятельными и смещенными и неэффективными. И, чем выше коррелированность, тем сильнее эффект искажения.

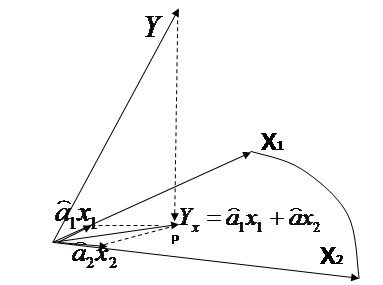

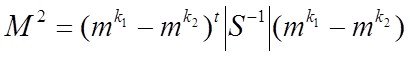

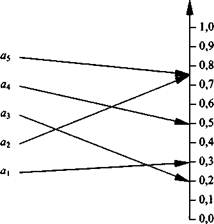

Покажем это, используя геометрическую интерпретацию получения МНК оценок параметров модели ![]() при аргументах х1 и х2,как коэффициентов проекции исходного вектора

при аргументах х1 и х2,как коэффициентов проекции исходного вектора ![]() в плоскость х1,х2.

в плоскость х1,х2.

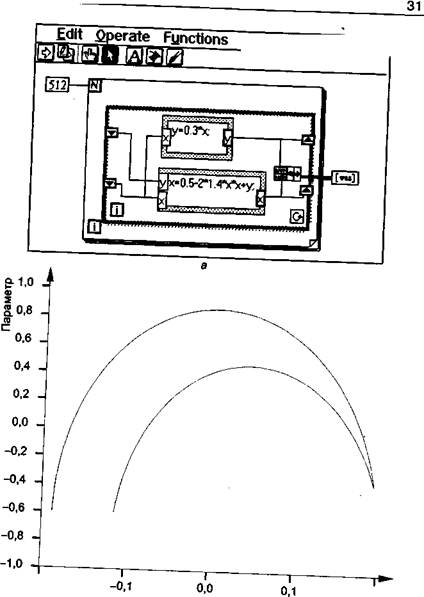

Интерпретацию покажем в пространстве точек (см рис.1) .

Очевидно, что если коррелированность аргументов возрастает, то уменьшается угол между векторами х1 и х2 ,. При малом угле (рис.2) даже совершенно ничтожный шум в данных влияет через коррелированность, как через увеличительное стекло, на смещение положение плоскости аргументов. И, чем меньше угол между векторами, которые определяют плоскость тем легче шум вращает плоскость аргументов.

![]()

Рис1 Рис 2 Рис 3 Рис 4

Рис 3 показывает случай коллинеарности векторов х1, х2, что позволяет плоскости вертеться на оси векторов и принимать любое положение. Соответственно и проекции (модели) в эти сдвинутые плоскости будут как угодно разные. Именно поэтому, наиболее предпочтительный вариант проекции в плоскость, это в плоскость, определенную ортогональными (независимыми), а еще лучше ортонормированными векторами –рис.4.

Здесь важно понять, что как только мы определились (выбрали), какими исходными векторами (х1, х2) определена плоскость, куда будем опускать проекцию – все, модель по сути, уже зафиксирована. Это будет проекция в эту плоскость. И все выше сказанное относится только к тому, как перезадать эту плоскость так, чтобы

А) вычислительный шум минимально повлиял на процесс определения проекции – надо перезадать плоскость ортогональными векторами и

Б) минимизировать сам вычислительный шум нормировав вектора аргументов

См рис 4

Кстати, именно поэтому, шум совсем не так страшен при оценке параметров, когда аргументы независимы – ортогональны: плоскость аргументов при этом максимально устойчива (к вращению шумом) и еще менее страшен, если он ортогонален к Х-ам и у,( тогда в случае ортогональности к выходу у он не войдет в модель, потому что корреляция его ![]() равна нулю с выходной переменной.

равна нулю с выходной переменной.

А устойчивость плоскости – определяет точность полученной проекции (нашей модели) в этой плоскости.

Отдельно проблема коллинеарности может оцениваться близостью главного детерминанта матрицы аргументов к нулю.

Совместное влияние коллинеарности и разброса длин векторов аргументов отражающееся на погрешности вычисления оценок характеризуется понятием обусловленности матрицы аргументов.

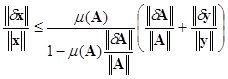

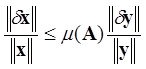

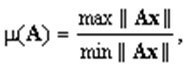

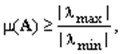

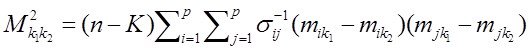

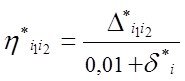

Степень обусловленности снизу оценивается т.н. числом обусловленности матрицы равным отношению максимального и минимального собственных собственных чисел матрицы аргументов.![]()

Чем данное отношение больше тем хуже степень обусловленности

Вопрос – ведь данные уже с шумом, значит, уже плоскость определена на неистинных коррелированных аргументах и это уже плохо. И если теперь ортогонализировать вектора – то вроде как «поздно пить боржоми». Но модель полученная на ортогональных векторах будет лучшая с точки зрения того что

1. когда новые вектора приходят и мы их подставляем в модель – выражение модели их преобразует так, как будто мы посчитали модель на независимых некоррелированных векторах, т.о. минимизируя эффект вращения плоскости, на которой мы посчитали значение модели (проекции)

2. Минимизирует нормировкой одну из причин вычислительного шума (а если максимум на которой делим при нормировании меньше 1?).

Итак, для коррелированных аргументов при небольших М (10-20) и Р (2-3) возможно решать задачу структурно параметрического синтеза через полное описание, ортонормируя его в обобщенных аргументах (скажем обобщенные аргументы для МНК формируются как ортогональные полиномы Форсайта).

Но при реальных размерностях практических задач мы опять вынуждены возвращаться к алгоритмам шаговой регрессии, где должна быть предусмотрена ортогонализация и нормировка аргументов при расчете их оценок по МНК (алгоритмы с ортогонализацией Грамма – Шмидта ..).

Справка

Обусловленность систем линейных уравнений

Две на первый взгляд похожие системы линейных уравнений могут обладать различной чувствительностью к погрешностям задания входных данных. Это свойство связано с понятием обусловленности системы уравнений.

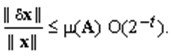

Числом обусловленности линейного оператора A, действующего в нормированном пространстве ![]() а также числом обусловленности системы линейных уравнений Ax = у назовем величину

а также числом обусловленности системы линейных уравнений Ax = у назовем величину

![]()